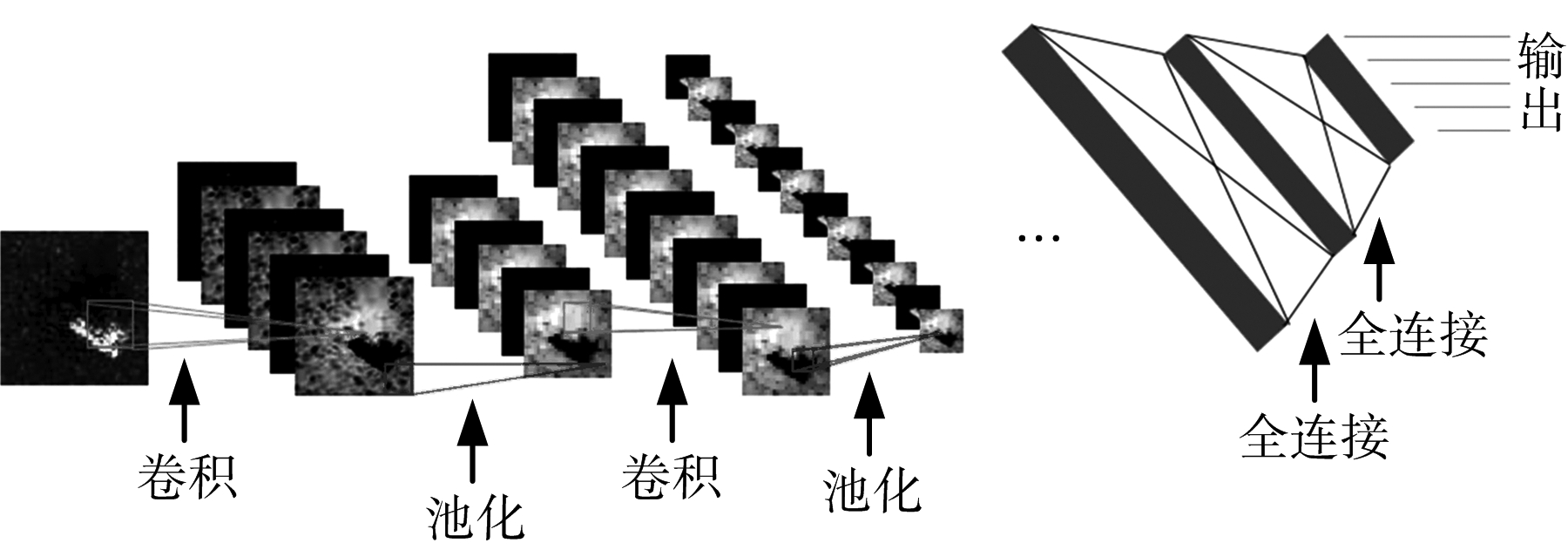

图1 CNN结构示意图

陈永生1,喻玲娟1,谢晓春2

(1.江西理工大学信息工程学院,江西赣州 341000;2.赣南师范大学物理与电子信息学院,江西赣州 341000)

摘 要:近年来,卷积神经网络(Convolutional Neural Network,CNN)在合成孔径雷达(Synthetic Aperture Radar,SAR)图像目标分类中取得了较好的分类结果。CNN结构中,前面若干层由交替的卷积层、池化层堆叠而成,后面若干层为全连接层。全卷积神经网络(All Convolutional Neural Network, A-CNN)是对CNN结构的一种改进,其中池化层和全连接层都用卷积层代替,该结构已在计算机视觉领域被应用。针对公布的MSTAR数据集,提出了基于A-CNN的SAR图像目标分类方法,并与基于CNN的SAR图像分类方法进行对比。实验结果表明,基于A-CNN的SAR图像目标分类正确率要高于基于CNN的分类正确率。

关键词:卷积神经网络; 全卷积神经网络; 合成孔径雷达; 目标分类

合成孔径雷达(Synthetic Aperture Radar,SAR)具有全天时、全天候工作能力,在军事和民用领域具有非常重要的意义。SAR自动目标识别(Automatic Target Recognition, ATR)[1]技术一直是SAR领域的研究热点。早期的SAR-ATR主要有3类方法:模板匹配法[2]、基于模型的方法[3]和机器学习方法。模板匹配法通过将提取的目标特征与样本库进行匹配以识别目标,识别方法简单,但需要采集大量的实测样本,难以实现。基于模型的方法无须采集大量的实测样本,但需要建立目标的三维模型和电磁散射模型,并根据模型参数对目标进行预测,该方法计算量大,难以满足实时性要求。机器学习方法需先获取目标的特征[4-5],后用分类器对特征进行分类,常用的分类方法有SVM[6],AdaBoost[7]等。该类方法比前两类方法效果好,但对不同的目标需设计不同的特征提取方法。

近年来,卷积神经网络(Convolutional Neural Network,CNN)在SAR-ATR方面取得了较大的进展。Morgan等率先将CNN应用于SAR-ATR中,并用MSTAR数据验证了该方法的性能。Michael等针对CNN的训练方法进行了研究,实验表明较好的初始值和修正的随机梯度下降法有助于获得更高的识别率。Housseini等提出了一种结合CNN和卷积自编码的识别方法,该方法能够在保持CNN原有识别率的情况下,有效减少运算时间[8]。Wagner利用CNN提取数据特征,然后将这些特征送入SVM分类器中进行分类[9]。Zhao等受递归神经网络的启发,提出了Highway Unit Network,在没有数据人工扩充的情况下对CNN进行训练[10]。Chen等用卷积层替换CNN中的全连接层,降低了过拟合风险[11]。

CNN的应用发展又反过来进一步推动其结构的发展。一个标准的CNN结构中,前面若干层由交替的卷积层、池化层堆叠而成,后面若干层为全连接层。CNN的结构在计算机视觉领域得到改进,Springenberg等将CNN结构中的池化层和全连接层都用卷积层代替,提出了全卷积神经网络(All Convolutional Neural Network, A-CNN),并分析了池化层可用卷积层代替的原因,实验结果验证了A-CNN的可行性[12]。文献[11]已证明CNN结构中,卷积层取代全连接层能够获得比原CNN更好的分类效果。本文将A-CNN应用到SAR-ATR中,针对公布的MSTAR数据集,提出了基于A-CNN的SAR图像目标分类方法,并与基于CNN的SAR图像分类方法进行对比。

一个标准的CNN结构如图1所示,前面若干层由交替的卷积层、池化层堆叠而成,后面若干层为全连接层。将输入层经过堆叠的卷积层和池化层后,能获取目标的特征,再将这些特征通过全连接层映射到类别空间,则可实现目标的识别和分类。

图1 CNN结构示意图

1) 卷积层

图1中,对于第l层卷积层,假定其输入的特征图为![]() 其中I表示输入特征图的总通道数。特别地,若l=1,则

其中I表示输入特征图的总通道数。特别地,若l=1,则![]() 表示输入图像。卷积输出后的特征图为

表示输入图像。卷积输出后的特征图为![]() 其中J表示输出特征图的总通道数。记连接第i个输入特征图和第j个输出特征图的卷积核为

其中J表示输出特征图的总通道数。记连接第i个输入特征图和第j个输出特征图的卷积核为![]() 其核大小为k×k,则卷积输出后的特征图的每个像素单元为

其核大小为k×k,则卷积输出后的特征图的每个像素单元为

![]()

![]()

(1)

式中,(x,y)表示![]() 的像素单元位置,(h,w)表示

的像素单元位置,(h,w)表示![]() 的像素单元位置,f(·)表示激活函数,如ReLU函数等。

的像素单元位置,f(·)表示激活函数,如ReLU函数等。

2) 池化层

考虑第l层卷积层之后的池化层,池化尺寸为G×G,步长为s,则池化输出后的特征图的每个像素单元为

(2)

式中,p表示p范数。特别地,当p→∞时,则式(2)为常用的最大池化。

3) 全连接层

输入图像经过若干层的卷积和池化后,得到多通道的特征图。将所有通道的特征图进行展开后,采用全连接层处理并输出目标所属类别,如图1所示。考虑第l层全连接层,其输入![]() 有n个神经元(i=1,2,…,n),其输出

有n个神经元(i=1,2,…,n),其输出![]() 有m个神经元(j=1,2,…,m)。记连接第i个输入神经元和第j个输出神经元的权重为

有m个神经元(j=1,2,…,m)。记连接第i个输入神经元和第j个输出神经元的权重为![]() 则

则

(3)

式中,f(·)表示激活函数。

A-CNN结构,即是在CNN结构基础上,用卷积层取代池化层和全连接层。

1) 卷积层取代池化层

文献[13]考虑了卷积层取代池化层的两种方案,本文考虑其中的一种,即用与池化层具有相同尺寸、步长的卷积层取代它。在第1.1节中,式(1)卷积运算主要是乘法和加法运算,式(2)主要是加法运算。对比式(1)和式(2)可知,式(2)可由式(1)变换得到。

进一步地,分别考虑卷积和池化运算前后数据尺寸的变化。对卷积运算而言,假定输入到卷积层的数据尺寸为W×H×I,其中,W为数据的宽,H为数据的高,I为特征图的通道数。卷积核大小为k×k,卷积步长为S,卷积核的数量为I,卷积过程中补0的数量为P。经过卷积后,其输出数据尺寸为W′×H′×I′,则

W′=(W-k+2P)/S+1

(4)

H′=(H-k+2P)/S+1

(5)

I′=I

(6)

对池化运算而言,若输入到卷积层的数据尺寸也为W×H×I,其中,W为数据的宽,H为数据的高,I为特征图的通道数。池化尺寸为k×k,池化步长为S,池化过程中补0的数量为P。经过池化后,其输出数据尺寸的计算公式和式(4)~式(6)相同。

2) 卷积层取代全连接层

由式(1)和式(3)可知,卷积层和全连接层都是主要完成乘加运算。即使两者输入和输出的数据维度不相同,它们之间也可以相互转化。文献[14]已证明了卷积层替换全连接层,不仅减少了参数运算量,而且降低了过拟合的风险。

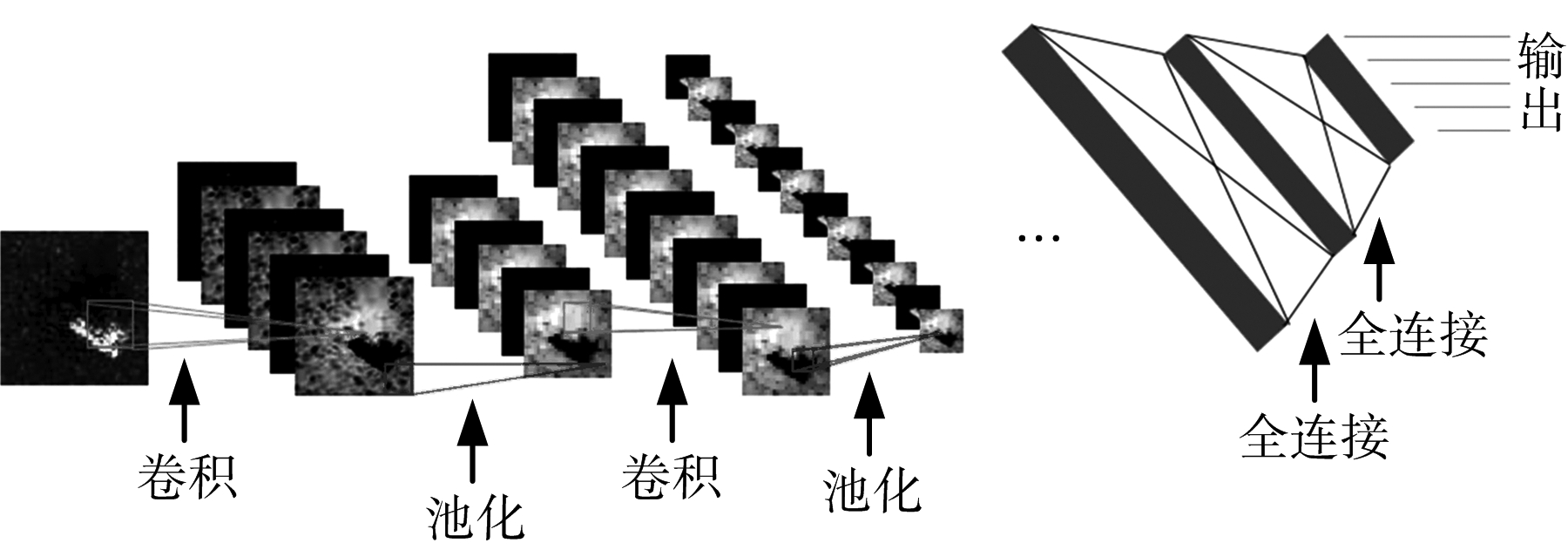

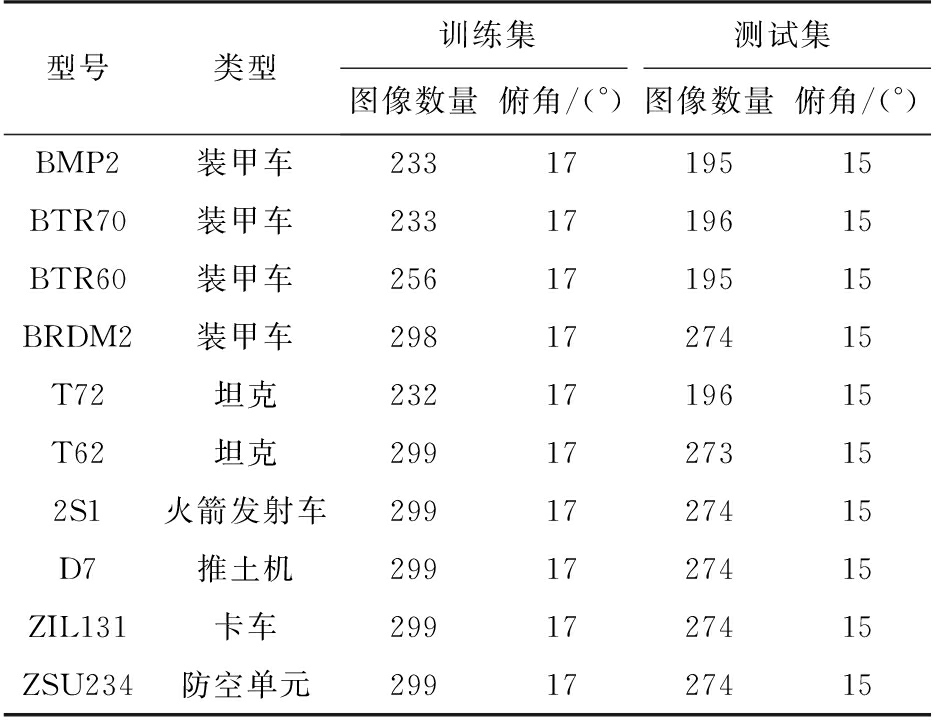

本文针对公布的MSTAR数据集,提出了基于A-CNN的SAR图像目标分类方法,其处理流程如图2(b)所示。为了便于比较A-CNN和CNN的性能,给出相应的基于CNN的SAR图像目标分类方法处理流程如图2(a)所示。

在图2(a)中,共有4个卷积层和最大池化层、3个全连接层。其中,在4个卷积层中,前两个是补0卷积,以使得卷积后输出特征图的大小与输入相同;后两个是不补0的有效卷积,其输出特征图的空间大小与卷积核大小有关。卷积前、后数据尺寸的关系如式(4)和式(5)。首先,输入大小为87×87的SAR图像。第一次经过大小为3×3的补0卷积后,得到16个大小为87×87的特征图,再经过大小为3×3、步长为2的池化层后,得到16个大小为43×43的特征图。第二次经过大小为3×3的补0卷积后,得到32个大小为43×43的特征图,再经过大小为3×3、步长为2的池化层后,得到32个大小为21×21的特征图。第三次经过大小为3×3的不补0卷积核后,得到64个大小为19×19的特征图,再经过大小为3×3、步长为2的池化层后,得到64个大小为9×9的特征图。第四次经过大小为3×3的不补0卷积核后,得到128个大小为7×7的特征图,再经过大小为3×3、步长为2的池化层后,得到128个大小为3×3的特征图。最后,将这些特征图进行展开后,输入到全连接层。经过第一个全连接层得到1×1×512的张量,经过第二个全连接层仍得到1×1×512的张量,再经过第三个全连接层得到1×1×10的张量,张量中每一个元素分别代表该图像所属类别的概率。

图2 SAR图像目标分类方法处理流程

与图2(a)相比,一方面,图2(b)中用卷积层取代了图2(a)中所有的池化层。卷积核的大小为3×3、步长为2。显然,卷积层每次取代池化层后,输出特征图的大小、输出特征图的通道数都和取代前池化层的输出保持一致。另一方面,图2(b)中用卷积层取代了图2(a)中的3个全连接层。卷积核的大小为3×3、步长为1。经计算,该卷积层输出仍为1×1×10的张量,张量中每一个元素分别代表该图像所属类别的概率。

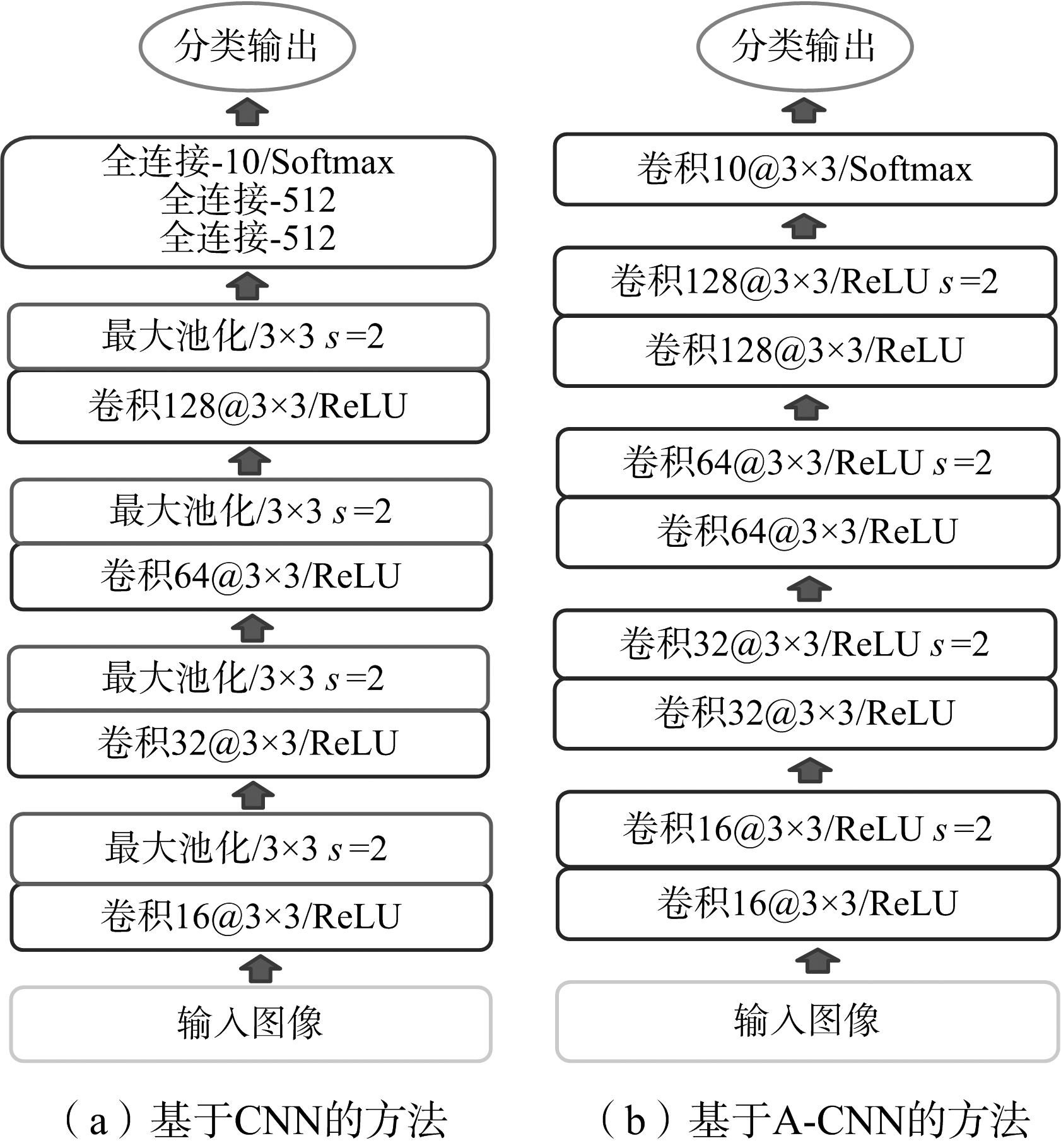

本文采用美国空军实验室公布的MSTAR数据集进行实验。该数据集由10类地面车辆的SAR图像组成,如装甲车、坦克、火箭发射车等。有关10类车辆的型号、类型、图像数量及采集参数等如表1所示。

表1 MSTAR数据集

由于A-CNN训练过程中,需要大量有标签数据来调节拟合网络参数,而MSTAR数据集有限,因此,本文采用人工方法来扩充数据集。

首先,为了尽可能使得扩展后的数据集包含目标的主要信息,将大小为128×128的原始SAR图像随机采样[11,14]成大小为87×87大小的切片,以保证每个切片包含目标的完整信息。经过随机采样成切片后,每类目标的训练样本数量扩充为原来的(128-87+1)×(128-87+1)=1 764倍。

然后,对每类目标选择3 200幅大小为87×87的样本图像,其中2 700幅用于训练,500幅用于验证。为了使所选的图像包含每个方位角的信息,对每幅SAR图像,在其扩充后的1 764幅图像中随机选取floor(3 200/n)+1幅作为该图像的扩充数据,其中n为该类数据集原有图像数量。以装甲车BMP-2为例,原有图像共233幅,经数据扩充后,每幅图像可扩充为1 764幅,从这1 764幅中随机选择floor(3 200/233)+1幅作为该图像的扩充数据。

此外,在A-CNN训练时,为了使网络能够快速收敛,对SAR图像数据作了减均值预处理。

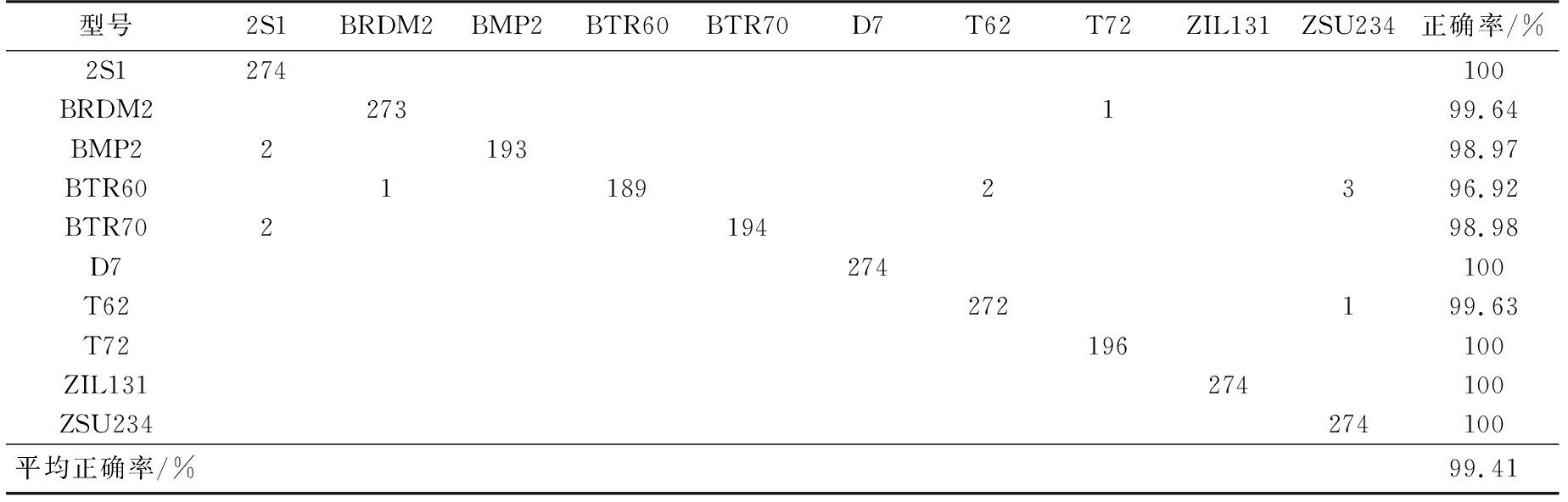

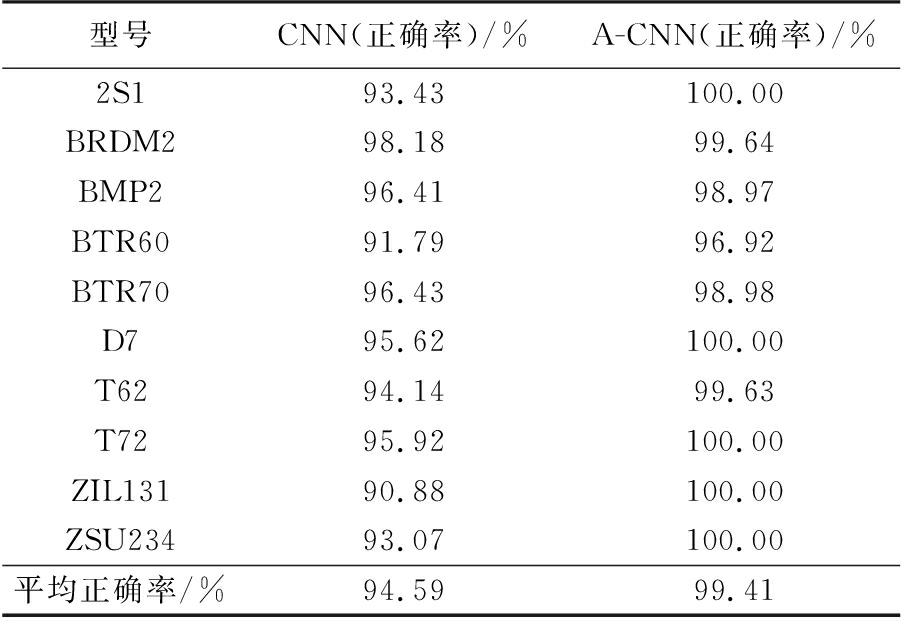

在对数据集进行扩充和预处理后,采用图2中基于A-CNN和基于CNN的SAR图像目标分类方法分别进行处理。实验中,使用俯仰角为17°的数据集作为训练集,俯仰角为15°的数据集作为测试集,如表1所示。训练过程中,采用随机梯度下降算法优化最小损失函数,动量设为0.95,权重衰减系数为0.005,初始学习速率为0.001。当验证集的精度和损失不再发生变化时,将学习速率降为初始速率的1/10[13]。依照此规则,直到学习速率降为10-7时停止训练。基于A-CNN的分类方法得到的混淆矩阵如表2所示,基于A-CNN和CNN的分类方法实验结果对比如表3所示。

表2 基于A-CNN的分类方法得到的混淆矩阵

表3 基于CNN和A-CNN的分类方法实验结果对比

表2结果表明,基于A-CNN的分类方法使得每类目标被正确分类的概率都较高,分类的平均正确率达到99.41%。表3结果表明,对于各种型号的目标,基于A-CNN的分类正确率比基于CNN的更高;基于A-CNN的平均分类正确率比基于CNN的高出4.82%。实验结果验证了卷积层取代池化层和全连接层的优势。

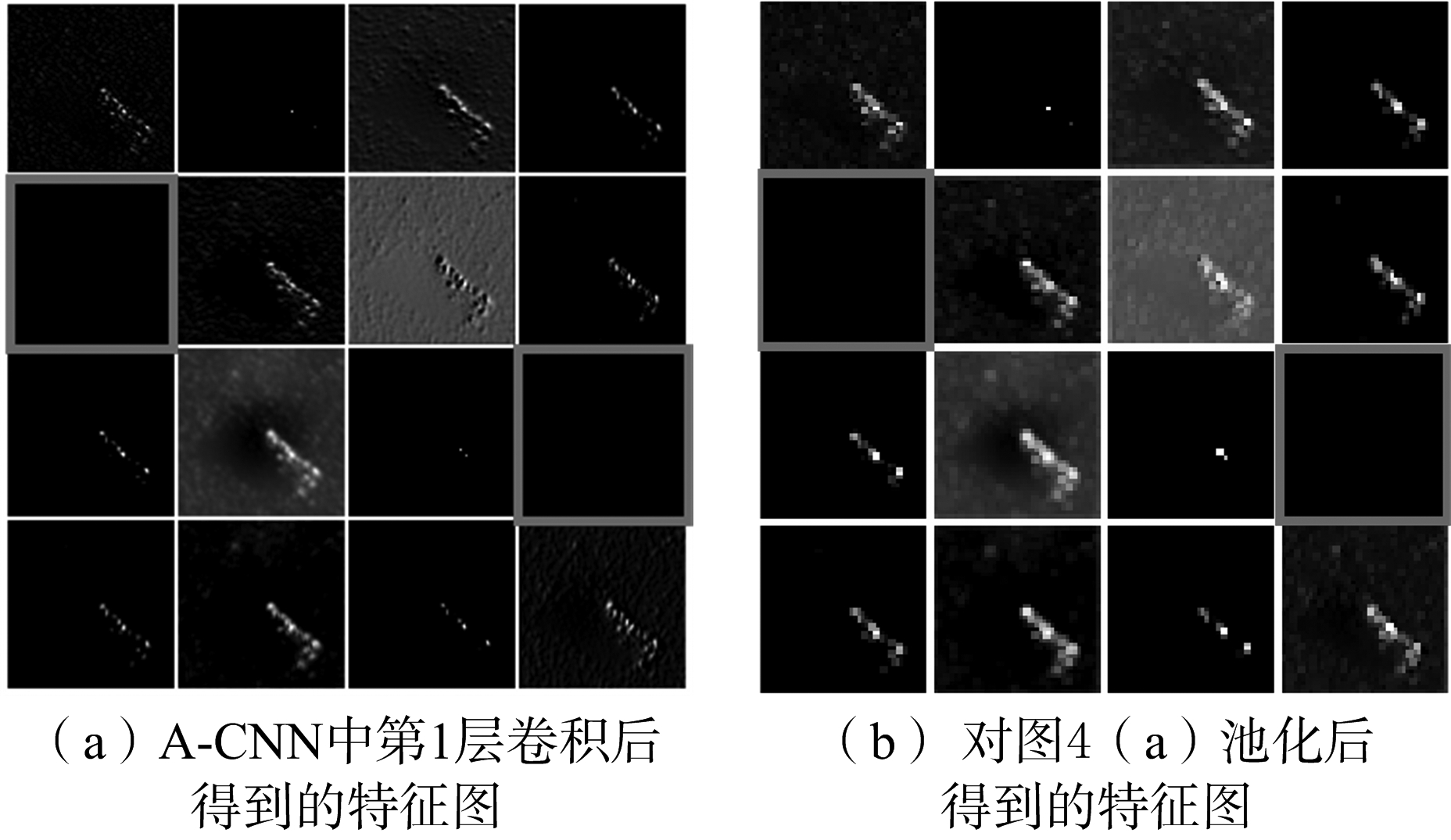

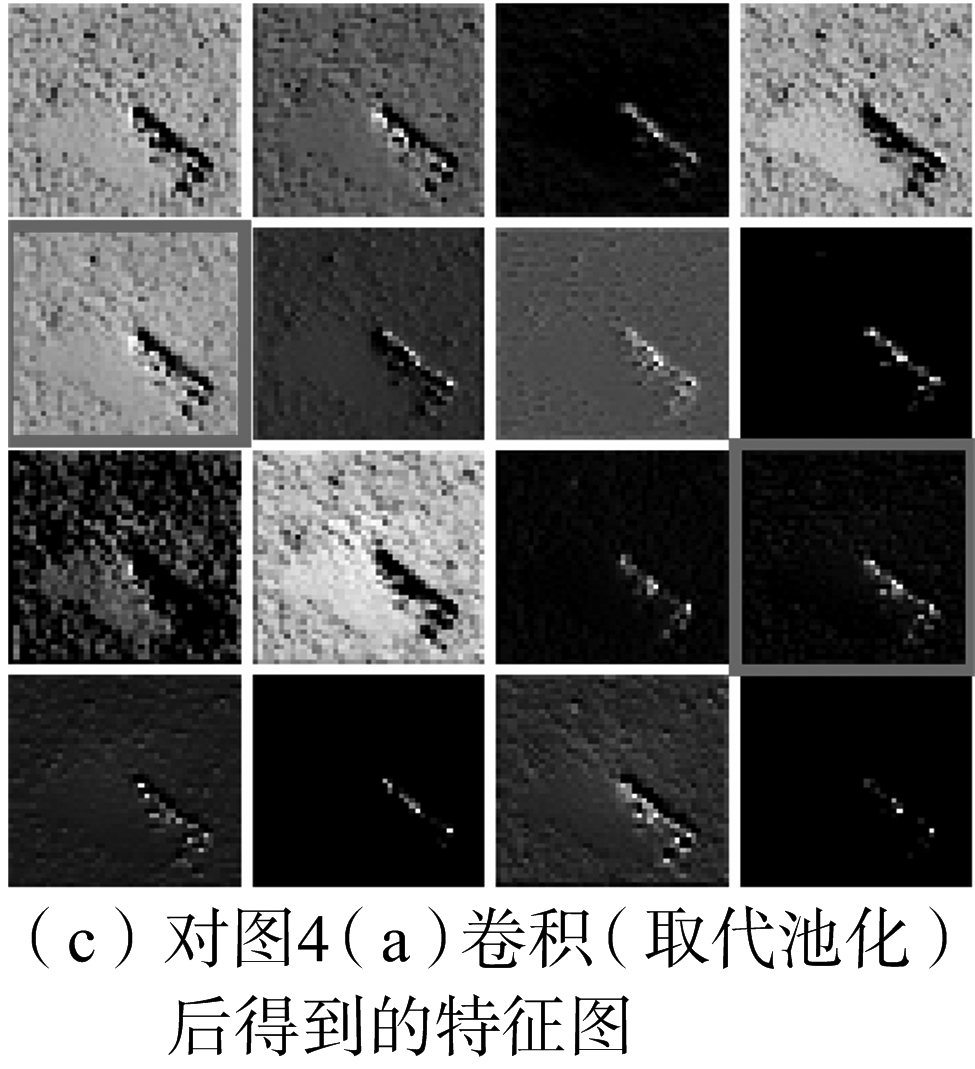

为了更好地解释其中使用卷积层替换池化层的优势,对A-CNN的前4个卷积核权重和卷积后特征图进行了可视化分析,结果分别如图3(a)和图3(b)所示。由于空间有限,图3(a)给出了部分的卷积核权重可视化结果。图3(b)中前2个卷积后特征图的可视化结果放大后分别如图4(a)和图4(c)所示。若将A-CNN第1个卷积层获取的特征图进行池化处理,其可视化结果如图4(b)所示。

图4(a)中,可以发现2个特征图为无用特征(红色方框内)。由于图4(b)是图4(a)降采样得到的结果,因此,与图4(a)相对应的2个特征图仍为无用特征(红色方框内)。而图4(c)是用卷积取代池化的结果,与图4(a)相对应的2个特征图变为有用特征(红色方框内)。因此,用卷积层取代池化层,不仅能实现池化层的降维,而且能激活前一个卷积层获取的无用特征(红色方框内)。此外,由于卷积层后使用了ReLU激活函数,因此,它比使用池化层具有更强的非线性能力。

进一步地,将基于CNN和A-CNN分类方法得到的前四层特征图进行可视化,结果分别如图5(a)和图5(b)所示。图5(a)中第1层卷积获取的3个无用特征图(红色方框内),经过第2层池化后仍为无用特征图。而图5(b)中第1层卷积获取的2个无用特征图(红色方框内),经过第2层卷积层后变为有用特征(红色方框内)。类似地,图5(a)中第3层卷积获取的2个无用特征图(红色方框内),经过第4层池化后仍为无用特征图。而图5(b)中第3层卷积获取的5个无用特征图(红色方框内),经过第4层卷积层后变为有用特征(红色方框内)。

图3 A-CNN前4个卷积核和卷积后特征图的可视化

图4 卷积层取代池化层前后特征图的对比

图5 两种分类方法的前4层特征图可视化

本文分别介绍了CNN结构中卷积层、池化层、全链接层的输出和输入之间的关系,并分析了A-CNN结构中用卷积层取代CNN结构中池化层和全连接层的可行性。针对MSTAR数据集,提出了基于A-CNN的SAR图像目标分类方法。实验结果表明,基于A-CNN的分类方法比基于CNN的方法能获得更高的分类正确率。此外,卷积后特征图的可视化结果表明,卷积层取代池化层能够将前一卷积层获取的无用特征激活。

参考文献:

[1] CUI Yi, ZHOU Guangyi, YANG Jian, et al. On the Iterative Censoring for Target Detection in SAR Images[J]. IEEE Geoscience and Remote Sensing Letters, 2011, 8(4):641-645.

[2] EL-DARYMLI K, GILL E W, MCGUIRE P, et al. Automatic Target Recognition in Synthetic Aperture Radar Imagery: A State-of-the-Art Review[J]. IEEE Access, 2017, 4:6014-6058.

[3] O’SULLIVAN J A, DEVORE M D, KEDIA V, et al. SAR ATR Performance Using a Conditionally Gaussian Model[J]. IEEE Trans on Aerospace and Electronic Systems, 2001, 37(1):91-108.

[4] 张琴,谷雨,徐英,等. 混合智能优化算法的SAR图像特征选择[J]. 遥感学报, 2016, 20(1):73-79.

[5] 甄勇,刘伟,陈建宏,等. 高分辨率SAR图像舰船目标几何结构特征提取[J]. 信号处理, 2016, 32(4):424-429.

[6] ZHAO Q, PRINCIPE J C. Support Vector Machines for SAR Automatic Target Recognition[J]. IEEE Trans on Aerospace and Electronic Systems, 2001, 37(2):643-654.

[7] SUN Y, LIU Z, TODOROVIC S, et al. Adaptive Boosting for SAR Automatic Target Recognition[J]. IEEE Trans on Aerospace and Electronic Systems, 2007, 43(1):112-125.

[8] HOUSSEINI A E, TOUMI A, KHENCHAF A. Deep Learning for Target Recognition from SAR Images[C]∥ Seminar on Detection Systems Architectures and Technologies, Algiers: IEEE, 2017:1-5.

[9] WAGNER S A. SAR ATR by a Combination of Convolutional Neural Network and Support Vector Machines[J]. IEEE Trans on Aerospace and Electronic Systems,2017, 52(6):2861-2872.

[10] LIN Zhao, JI Kefeng, KANG Miao, et al. Deep Convolutional Highway Unit Network for SAR Target Classification with Limited Labeled Training Data[J]. IEEE Geoscience and Remote Sensing Letters, 2017, 14(7):1091-1095.

[11] CHEN Sizhe, WANG Haipeng, XU Feng, et al. Target Classification Using the Deep Convolutional Networks for SAR Images[J]. IEEE Trans on Geoscience and Remote Sensing, 2016, 54(8):4806-4817.

[12] SPRINGENBERG J T, DOSOVITSKIY A, BROX T, et al. Striving for Simplicity: The All Convolutional Net[C]∥ International Conference on Learning Representations, Hilton, San Diego: ICLR, 2015:1-14.

[13] MONTAVON G, ORR G B, MÜLLER K R. Neural Networks: Tricks of the Trade[M]. 2nd ed. Heidelberg: Springer, 2012:437-478.

[14] KRIZHEVSKY A, SUTSKEVER I, HINTON G E. ImageNet Classification with Deep Convolutional Neural Networks[C]∥ 25th International Conference on Neural Information Processing Systems, Lake Tahoe, Nevada: ACM, 2012:1097-1105.

CHEN Yongsheng1, YU Lingjuan1, XIE Xiaochun2

(1.School of Information Engineering,Jiangxi University of Science and Technology,Ganzhou341000,China;2.School of Physics and Electronic Information,Gannan Normal University,Ganzhou341000,China)

Abstract:Convolutional neural network (CNN) has achieved good performance in the target classification of synthetic aperture radar (SAR) images. In the CNN structure, the preceding layers are stacked by alternating convolutional and pooling layers, while the latter layers are the fully-connected layers. The all convolutional neural network (A-CNN) is an improvement on the CNN structure, where the pooling and fully-connected layers are replaced by convolutional layers. It has been applied in the field of computer vision. In this paper, a method of SAR image target classification based on A-CNN is proposed. A comparison of the proposed method with CNN-based method by use of the published MSTAR data set. The experimental results show that the accuracy of SAR image classification based on A-CNN is higher than that of CNN.

Key words:convolutional neural network (CNN); all convolutional neural network; synthetic aperture radar(SAR); target classification

中图分类号:TN958; TN957.5

文献标志码:A

文章编号:1672-2337(2018)03-0242-07

DOI:10.3969/j.issn.1672-2337.2018.03.002

收稿日期:2017 09 26;

修回日期:2017 11 06

基金项目:国家自然科学基金(No.61501210);江西省自然科学基金(No.20161BAB202054);江西省教育厅科技项目(No.GJJ150684)

作者简介:

陈永生 男,1989年生,河南郑州人,江西理工大学信息工程学院硕士研究生,主要研究方向为机器学习、深度学习网络及在雷达图像中的应用。E-mail:chenys1989@hotmail.com

喻玲娟 女,1982年生,江西高安人,2012年获中国科学院空间科学与应用研究中心博士学位,江西理工大学信息工程学院副教授、硕士生导师,主要研究方向为合成孔径雷达成像处理、合成孔径雷达图像自动目标识别。

谢晓春 男,1975年生,江西赣州人,2010年获中国科学院空间科学与应用研究中心博士学位,赣南师范大学物理与电子信息学院副教授、硕士生导师,主要研究方向为合成孔径雷达信号处理。