0 引 言

随着智能设备的普及与人工智能技术的快速发展,人机交互技术变得愈加重要。人体动作识别技术作为推动人机交互发展的关键技术之一,在智能家居、健康监测与护理、安防与监控等诸多领域具有重要应用价值,成为近年来国内外的研究热点[1]。

目前,用于人体动作识别的设备可分为接触式与非接触式两种。常见的接触式设备包括智能手机、手表或由加速度计、振动陀螺仪等传感器组合而成的人体动作检测装置[2-4]。然而,接触式设备需要直接接触或佩戴在用户身上,这往往会对用户的自由度与舒适度造成一定的限制。因此,许多研究人员将目光转向了非接触式的人体动作识别方式。通常可以使用RGB 视频、WiFi 或毫米波雷达实现非接触式人体动作识别。基于视频的人体动作识别技术发展成熟,其一般采用不同的深度学习技术,对RGB 视频或人体骨架数据进行处理以实现人体动作的识别[5-6]。但是基于视觉的人体动作识别方法对光线条件的依赖度高,并且存在泄露用户隐私的风险。基于WiFi的方法具有成本低、易于部署、保护隐私的优点[7-8]。然而,WiFi 容易受到其他无线信号的影响,并且它的分辨率较低,稳定性也较差。相比之下,毫米波雷达有着分辨率高、设备尺寸小以及不依赖光源的特点,为非接触式人体动作识别提供了一种可行的解决方案。同时,深度学习技术的快速发展推动了基于雷达的人体动作识别技术的进步。文献[9]系统介绍了调频连续波(Frequency Modulated Continuous Wave, FMCW)雷达的基本工作原理与基于离散傅里叶变换的信号处理技术。文献[10]使用毫米波雷达采集人体的点云信息,并选取其中一点作为质心点云,然后根据所获取的点云计算人体运动的异常水平,当异常水平的尖峰与质心点云高度的下降同时发生时,则检测为跌倒。文献[11]与文献[12]根据人体动作微多普勒特征,分别使用光学字符识别技术以及深度卷积神经网络(Deep Convolutional Neural Network,DCNN)实现了对多种人体动作的识别。文献[13]将人体动作距离特征与微多普勒特征进行融合得到双流融合特征,并将其输入至Bi-LSTM网络以实现对不同人体动作的识别。文献[14]提出了一种多分支卷积神经网络结构,用于提取手势目标的距离、多普勒与角度参数的高维特征,并采用特征拼接融合的方式对手势进行识别。以上工作说明了深度学习技术应用于雷达人体动作识别的可行性。然而,现有基于毫米波雷达的人体动作识别方法存在以下问题:第一,因为使用毫米波雷达生成的点云数据具有稀疏性与随机性,所以基于点云的方法难以对较为轻微的动作进行识别;第二,对人体动作特征信息的利用不够充分,例如文献[11]与文献[12]仅利用了人体动作的微多普勒特征,文献[13]仅利用了人体动作的距离特征与多普勒特征,两者都缺乏对人体动作角度特征的利用;第三,对多维特征融合的方式较为简单,文献[14]采用特征拼接的方式对多维特征进行融合,而这种方式会导致模型参数量以及计算复杂度的增加,同时容易引入过拟合与网络冗余信息增加的问题。

针对上述问题,本文提出了基于毫米波雷达的三维特征自适应融合人体动作识别算法。首先,采用二维快速傅里叶变换(2-Dimensional Fast Fourier Transform,2D-FFT)与多信号分类(Multiple Signal Classification, MUSIC)算法[15]对雷达回波信号处理得到人体动作距离、多普勒与角度特征,并在时间上拼接构建三维特征数据集。其次,为了能够同步提取三维特征数据集中的高维抽象特征,设计了一种三分支卷积神经网络结构,解决了特征输入维度不足的问题。然后,提出了一种特征自适应融合方案,解决了由特征拼接融合方法带来的模型参数量与计算复杂度增加的问题,减少了模型过拟合的风险。最后通过活动分类器获得识别结果。为了证明本文方法的有效性,将其与单维特征识别方法、多维特征拼接融合与平均融合方法进行对比。实验结果表明,采用多维特征自适应融合方法的网络具有更高的人体动作识别精度与AUC值。

1 算法描述

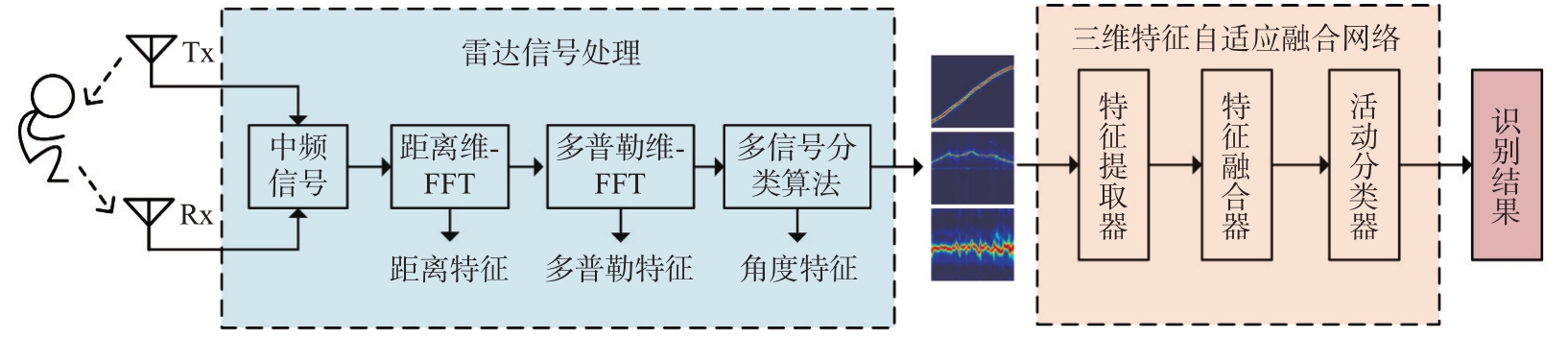

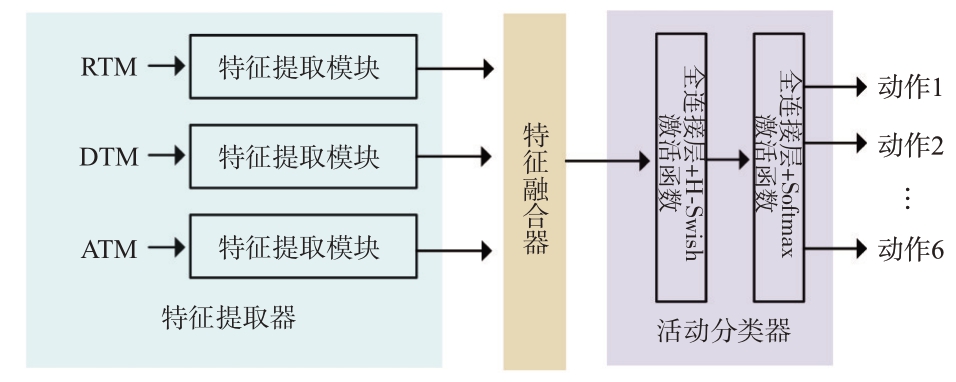

本文提出了基于毫米波雷达的三维特征自适应融合人体动作识别系统。如图1所示,该系统主要包括FMCW 雷达信号处理、多维特征数据集构建与三维特征自适应融合卷积神经网络(Three-Dimensional Feature Adaptive Fusion Network, 3D -FAFNet)设计部分。首先,采用距离维-FFT与多普勒维-FFT 对雷达回波信号进行处理以获取人体动作距离、多普勒特征,采用MUSIC 算法获取人体动作角度特征,并在时域上拼接构建三维特征数据集。其次,设计了3D-FAFNet 网络,实现对不同人体动作的识别。

图1 人体动作识别系统框图

1.1 FMCW 雷达信号处理

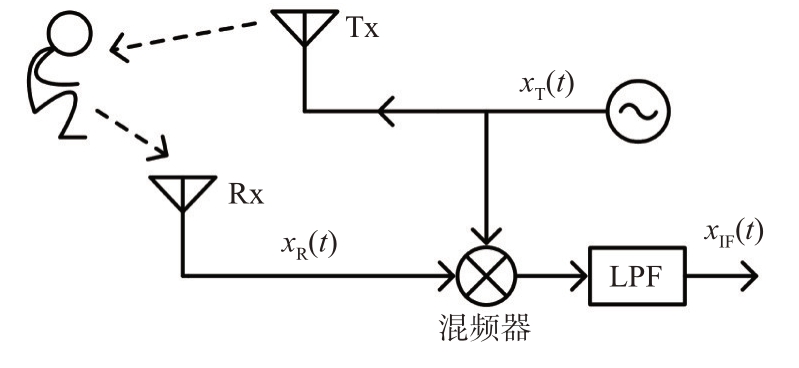

本文采用FMCW 毫米波雷达进行信号采集,其系统框图如图2 所示。雷达系统从发射天线发射LFM信号xT(t),表示为[9]

图2 雷达系统框图

式中,AT 为发射信号的幅度,fc 为起始频率,S 为调频斜率,B为带宽,Tc为扫频周期。

当雷达前方存在目标时,部分信号能量被反射至接收天线,得到接收信号xR(t),表示为

式中,AR 为接收信号的幅度,τ 为时延。然后,将发射信号与接收信号进行混频得到混频信号xM(t) =xT(t)· xR(t),同时使用低通滤波器(Low-Pass Filter,LPF)滤除混频信号的高频分量,得到中频信号为

可知中频信号的频率与初始相位分别为

假设人体动作目标与雷达之间的距离为R,结合公式(5)可得

式中,c = 3 × 108 m/s为光速。

为了估计目标的速度,雷达会发射多个时间间隔为Tc 的线性调频脉冲信号。若目标的速度为v,则在时间间隔Tc 内目标的位移ΔR = vTc。结合公式(6)、(7)知相邻线性调频信号之间的相位差Δϕ = 4πΔR λ = 4πvTc/λ,则目标速度为

式中,λ = c/fc为信号波长。

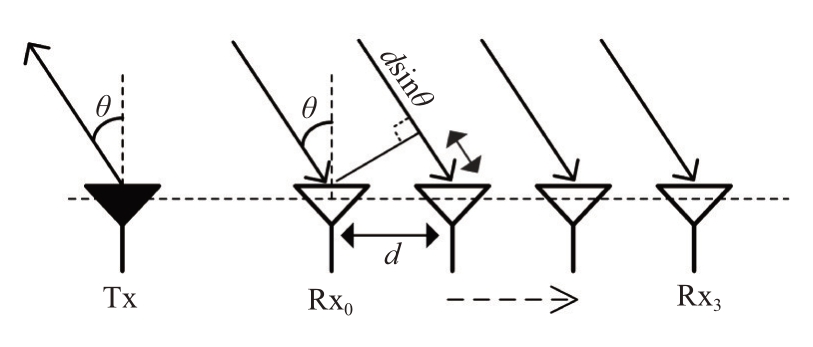

如图3所示,可利用多个天线之间的雷达回波信号的相位差测量目标的角度信息。由于天线之间存在间隔,到达两个相邻接收天线的信号所经历的相对延迟可以被确定为Δτ = d sin θ c,其中,d为天线间距,θ 为接收信号的到达角。结合公式(6)可得两个相邻天线处所接收信号的相位差为

图3 角度估计原理图

则目标角度为

1.2 数据集构建

为了获取人体动作目标相对于雷达距离、多普勒与角度随时间变化的信息,本文对雷达回波信号进行时频分析以提取人体动作目标在每一帧上的距离、多普勒与角度特征,在时间上拼接分别得到距离-时间图(Range-Time-Map,RTM)、多普勒-时间图(Doppler-Time-Map,DTM)以及角度-时间图(Angle-Time-Map,ATM)。

本文以48 帧数据为观测时长,每一帧的持续时间为40 ms。人体动作目标在一帧时间内相对于雷达的位置近乎不变。在一帧数据内,对每个扫频信号执行Range-FFT 求出其对应的距离估计谱,然后在帧内求平均得到一帧数据的人体动作目标距离特征,对多帧数据的距离特征进行拼接可得到RTM。在得到一帧数据内所有扫频信号的距离估计谱后,在慢时间维上执行Doppler-FFT 得到距离-多普勒联合估计结果,通过谱峰搜索提取一帧数据的人体动作目标多普勒特征,经过拼接多帧数据的多普勒特征后得到DTM。本文采用的雷达具有2 个发射天线以及4 个接收天线,通过时分复用技术可构建8路信号向量矩阵,从而可以利用MUSIC 算法提取人体动作目标的角度特征,将多帧数据的角度特征拼接后得到ATM。

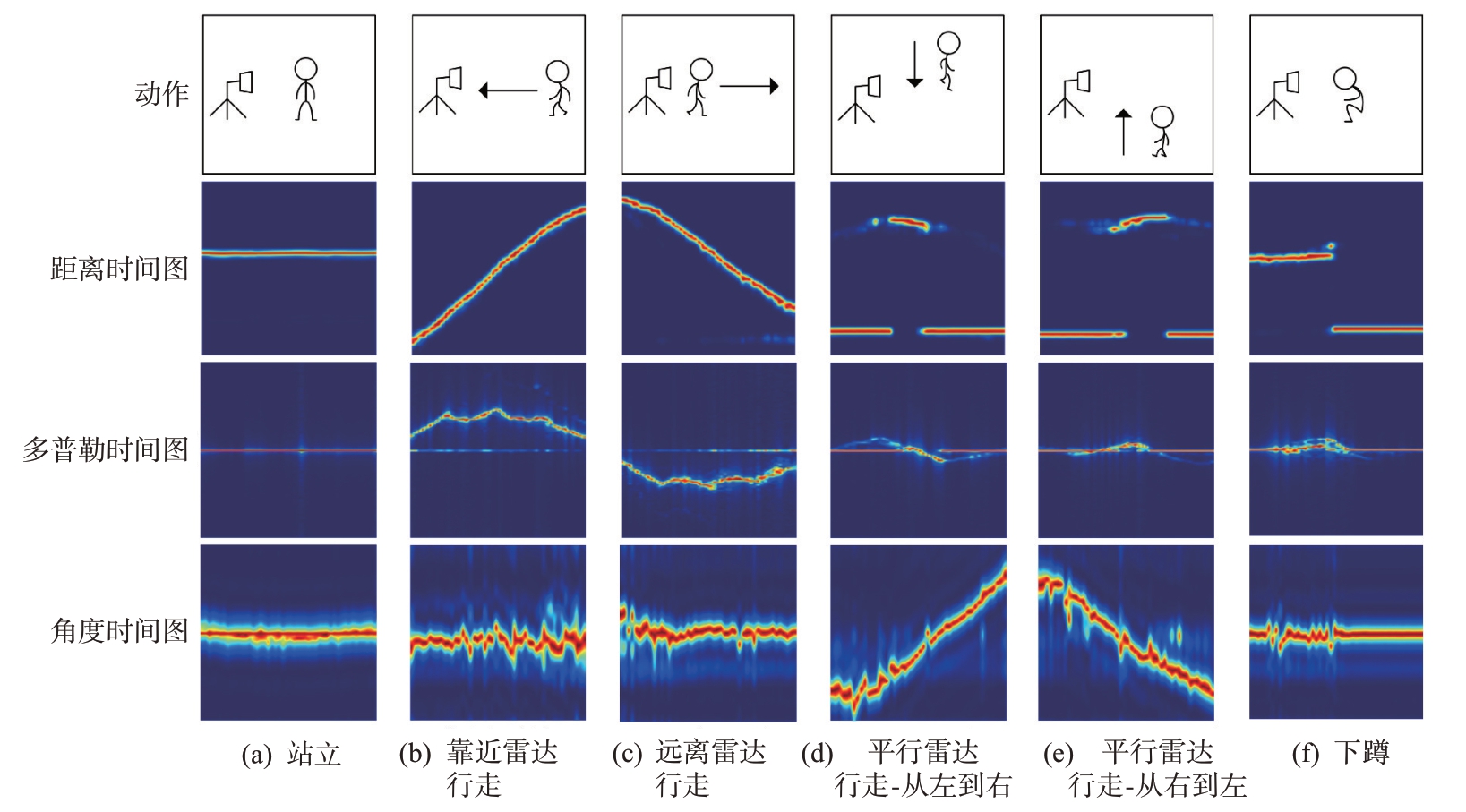

本文选取的人体动作包括站立(Stand)、靠近雷达行走(Walk Close to the radar, WC)、远离雷达行走(Walk Away from the radar, WA)、平行雷达行走-从左至右(Walk Parallel to the radar-Left to Right,WP-LR)、平行雷达行走-从右至左(Walk Parallel to the radar-Right to Left,WP-RL)、下蹲(Squat)共6类。为了使数据集更加多样化,实验邀请了年龄、身高和体重各不相同的11 名志愿者进行数据采集。每名志愿者重复执行每种动作50 次,每种人体动作采集550 次,共计3 300 组数据。在图4 中,本文给出了完整的人体动作图以及不同人体动作对应的RTM、DTM、ATM 结果,易知,不同人体动作对应的RTM、DTM、ATM 表现出了不同的物理特征。例如,在靠近雷达行走动作中,人体动作目标不断接近雷达,故其对应的RTM 呈现为一条逐步上升的曲线,DTM 的能量主要集中在上半区域。而远离雷达行走动作对应的RTM、DTM 结果则呈现了相反的变化趋势。因为靠近雷达行走动作与远离雷达行走动作的行走路线接近为一条直线,故这两个动作的ATM 结果波动较小,类似于一条直线。

图4 不同人体动作对应的距离时间图、多普勒时间图、角度时间图结果

1.3 3D-FAFNet网络设计

卷积神经网络能够通过局部感知性捕捉图像边缘、纹理等局部特征,并采用堆叠多个卷积层与池化层的方式逐层提取图像数据的高维抽象特征,在图像数据处理方面具有巨大的优势。为了有效提取RTM、DTM 与ATM 数据的高维抽象特征,并实现对多维特征的自适应融合,本文设计了一种三维特征自适应融合卷积神经网络。如图5所示,3D-FAFNet 由特征提取器、特征融合器和活动分类器组成。其中,3D-FAFNet的特征融合器采用的是特征自适应融合方法。

图5 3D-FAFNet结构图

1.3.1 特征提取器

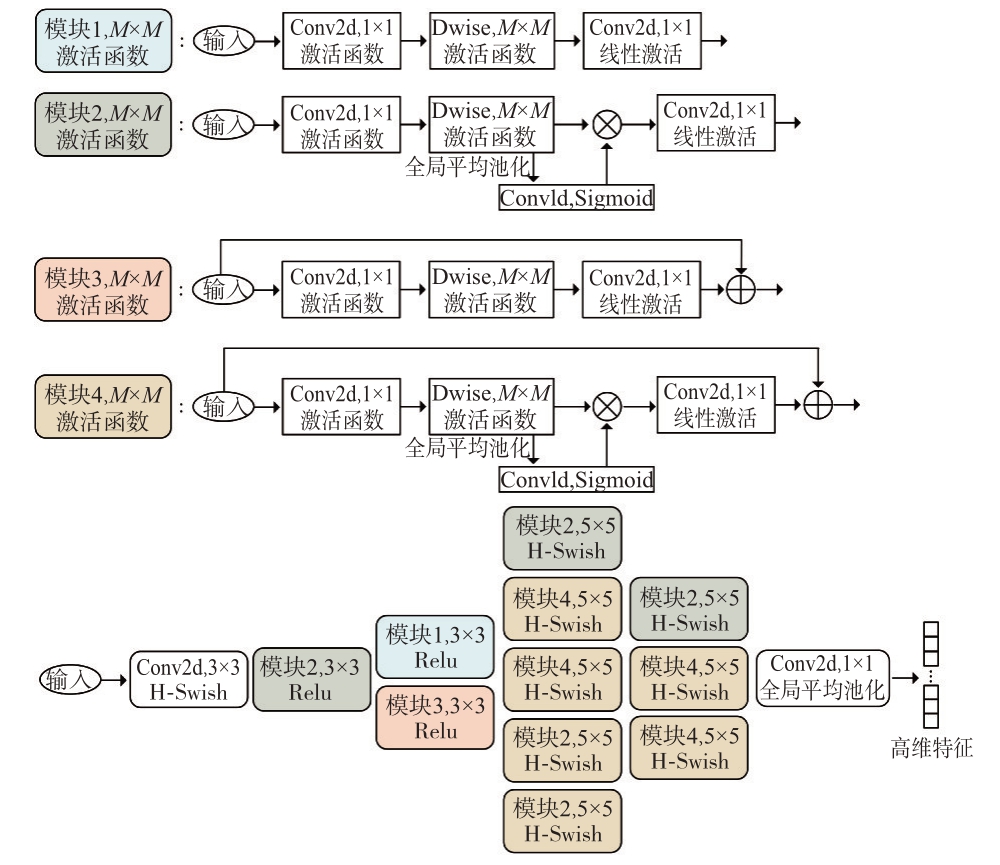

3D-FAFNet 的特征提取器由3 个相同的特征提取模块(Feature Extraction Module, FEM)构成,是一种三分支卷积神经网络结构。其中,3 个特征提取模块的输入依次为RTM、DTM 以及ATM 数据,每个特征提取模块都是由MobileNetV3-Small[16]网络改进而来,将其中的SE 通道注意力机制[17]更改为ECA 通道注意力机制[18],目的在于避免SE通道注意力机制中的降维处理对通道注意力预测带来的副作用,更加有效地捕获局部跨通道交互信息。如图6 所示,FEM 由4 种Block 组成。其中,Block1 与Block2 中的深度卷积核(Depthwise convolution, Dwise)的步长为2,Block3 与Block4 中深度卷积核的步长为1。当步长为1 时,输出图像的长和宽与输入图像相同;当步长为2 时,输出图像的长和宽缩短为原来的一半。Block2 与Block4包含ECA 通道注意力机制,而Block1 与Block3 则不包含。每个Block 中的Activation 表示激活函数的类型,M×M则表示深度卷积核的尺寸大小。

图6 FEM结构图

1.3.2 特征融合器

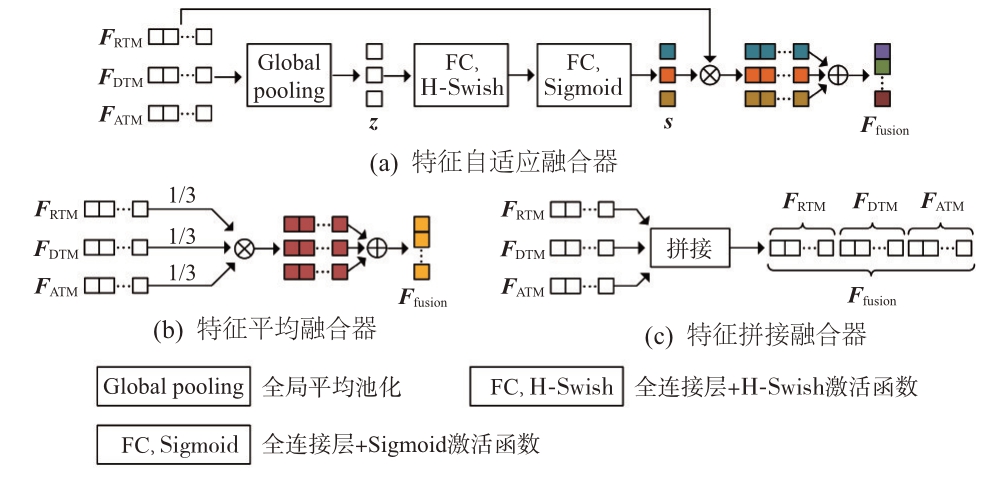

特征融合器能够融合所提取的RTM、DTM、ATM 高维抽象特征,可以更充分地利用不同的人体动作特征,获得更丰富的特征表示,如图7所示,不同的特征融合方法拥有不同的特点,每种特征融合器的输入为所提取的RTM、DTM、ATM 高维抽象特征FRTM、FDTM与FATM。

图7 不同特征融合器结构图

如图7(a)为特征自适应融合器结构图。首先对每个高维抽象特征使用全局平均池化得到压缩后的特征表示z:

式中,n 为每一类高维抽象特征的长度,i表示高维抽象特征的类别,i = 1,2,3,Fi(j)表示第i类高维抽象特征的第j 个元素。然后采用两个带有不同激活函数的全连接层(Fully-Connected layer,FC)获取特征权重因子s:

式中,![]() 为H-Swish 激活函数[19],σ为Sigmoid 激活函数。最后,将每个高维抽象特征与其相对应的特征权重进行相乘,并以相加的方式完成特征的自适应融合,得到融合特征Ffusion为

为H-Swish 激活函数[19],σ为Sigmoid 激活函数。最后,将每个高维抽象特征与其相对应的特征权重进行相乘,并以相加的方式完成特征的自适应融合,得到融合特征Ffusion为

如图7(b)所示,作为特征自适应融合方法的消融方法,本文人工地为每个高维抽象特征赋予1/3的特征权重并以加权求和的方式完成特征融合,设计了特征平均融合器,此时的融合特征为

易知,相比于特征自适应融合方法,特征平均融合方法不能自适应地为不同的人体动作特征赋予不同的权重,缺乏一定的灵活性,从而限制了网络的特征融合能力。

如图7(c)所示,文献[14]采用特征拼接的方法对多维特征融合,得到的融合特征为

式中,[·,·]为向量首尾拼接符。

卷积神经网络模型的参数量通常与模型的复杂度相关联。卷积神经网络全连接层的参数量为Tin · Tout + Tout,其中Tin 为输入向量的长度,即为融合特征的长度,Tout 为输出向量的长度。可知对于同一种网络模型,特征拼接融合方法在全连接层产生的参数量约为特征自适应融合与特征平均融合方法的3倍,而过多的参数量会导致网络计算复杂度的增加,同时容易引入网络冗余信息增加与过拟合的问题[20]。

1.3.3 活动分类器

活动分类器由两层全连接层组成,其输入为融合特征Ffusion。在第一层全连接层后引入HSwish激活函数,以增强模型的非线性表达能力,并在第二层全连接层后使用Softmax 激活函数,获得每一类人体动作的检测概率:

式中,![]() 为第一个全连接层的输出通道数,ρ 为Softmax 激活函数。为了与MobileNetV3-Small 网络保持一致,本文选取n = 576,m = 1 024。

为第一个全连接层的输出通道数,ρ 为Softmax 激活函数。为了与MobileNetV3-Small 网络保持一致,本文选取n = 576,m = 1 024。

本文的损失函数为交叉熵损失函数,交叉熵能够衡量两个分布的差异程度,其公式定义如下:

式中,P(xk)表示真实概率分布,Q(xk)表示预测概率分布,xk表示人体动作的类别。通过计算交叉熵损失函数,能够得知两个分布的差异程度,之后在反向传播过程中不断更新模型的权重参数,并计算特征权重因子s,达到三维特征自适应融合的目的。

2 实验分析与讨论

2.1 实验平台与环境

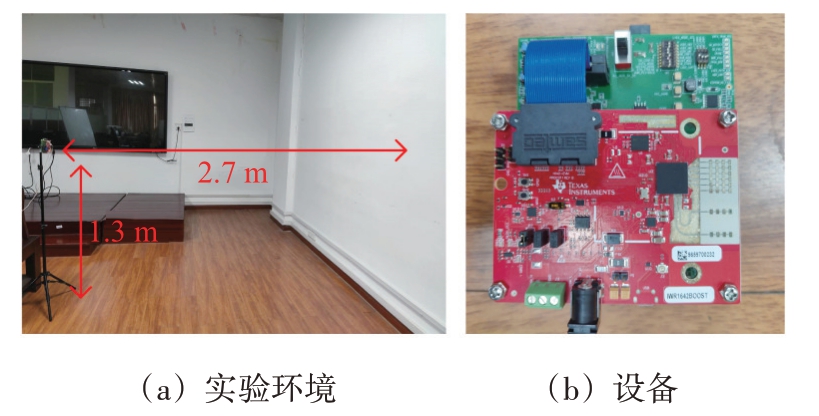

如图8 所示,本文使用德州仪器(Texas Instruments, TI)公司的IWR1642Boost 毫米波雷达开发板以及DCA1000 高速数据采集卡完成对数据的采集。雷达扫频周期为38 μs,帧周期为40 ms,带宽约为4 GHz。实验环境为一个空旷的会议室,雷达距离前方墙体约2.7 m,距离地面约1.3 m,实验人员在雷达与墙体之间的范围内执行不同的动作。3D-FAFNet 网络由Pytorch 深度学习框架搭建而来,采用NVIDIA 公司的GTX 1070 显卡实现对模型的加速训练与测试。

图8 实验环境与设备图

2.2 单维特征网络验证

为了探究不同特征对人体动作识别贡献程度的大小,并证明三维特征数据集相较于单维特征数据集的优势,本文将3D-FAFNet 网络修改为单分支卷积神经网络结构,即只保留一个特征提取模块作为网络的特征提取器,同时去除特征融合器。在实验中,本文将每种数据集划分为训练集、验证集与测试集。训练集用于模型的训练与网络参数的更新,验证集用于选择训练过程中生成的最佳模型,测试集用于评估所选择模型的泛化能力。其中,训练集包含2 160 组数据,验证集包含540 组数据,测试集包含600 组数据,且训练集、验证集与测试集中的数据都是互不重合的。为了让模型具有更好的适应性,对于在不同时刻、不同位置执行人体动作的实验人员仍具有较高的人体动作识别准确率,同时为了减少模型的计算复杂度,将图像尺寸均随机缩放为96×96,并进行灰度归一化处理。采用带有动量与权重衰减的随机梯度下降优化器,初始学习率设置为0.02,动量为0.9,并基于余弦衰减的方法[21]设置学习率调度器。

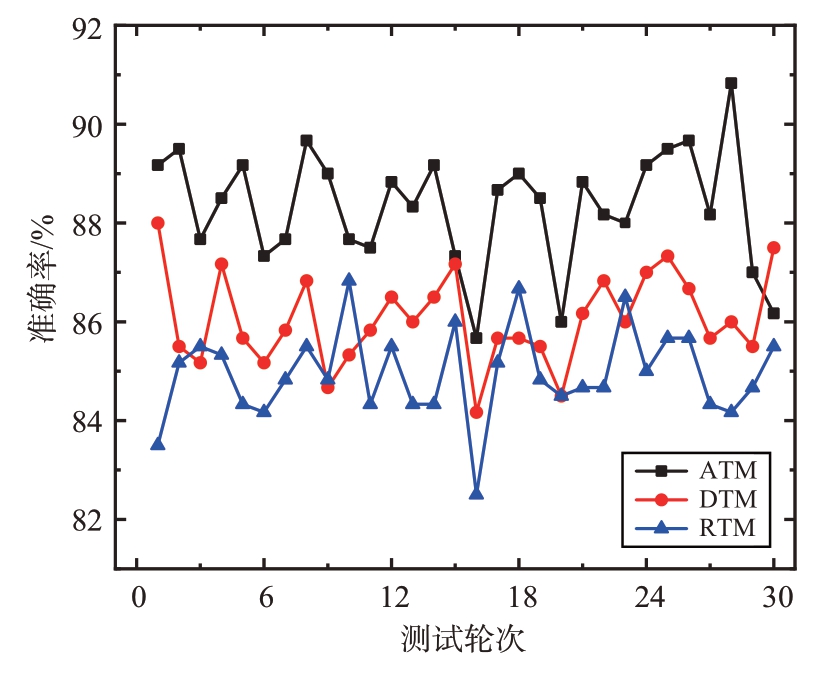

卷积神经网络在测试集上的准确率变化曲线能够有效反映模型的泛化能力。如图9 所示为经过训练与验证后所得到的RTM、DTM、ATM 最佳模型在各自测试集上进行30轮测试的准确率变化曲线。可见,不同数据集最佳模型在各自测试集上的平均准确率从高到低依次为ATM、DTM、RTM。说明ATM 数据集能够提供更多的人体动作特征差异信息,具有更好的人体动作表征能力。同时,由ATM 数据集训练与验证后保存的最佳模型具有更强的泛化能力。

图9 RTM、DTM、ATM准确率变化曲线

2.3 三维特征网络验证

为了证明本文提出的特征自适应融合器对网络性能的提升,本文将3D-FAFNet 中的特征自适应融合器替换为特征平均融合器,构建三维特征平均融合网络(Three-Dimensional Feature Mean Fusion Network, 3D-FMFNet),与三维特征自适应融合网络进行比较。如图10为采用不同特征融合方法的网络经过训练与验证后得到的最佳模型在三维特征测试集上的准确率变化曲线。由图10可知,采用特征自适应融合方法的人体动作识别准确率明显高于特征平均融合方法,这表明相比于特征平均融合方法,特征自适应融合方法能够自动地为不同的人体动作特征赋予不同的权重,让网络能够更好地关注重要的特征信息并抑制不重要的特征信息,从而有效提升网络的人体动作识别性能。

图10 3D-FAFNet与3D-FMFNet准确率变化曲线

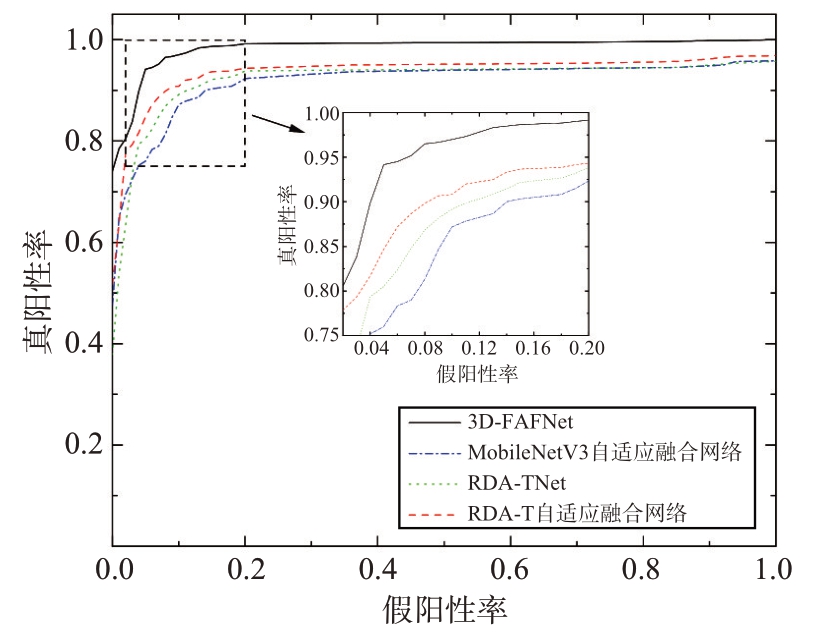

为了验证3D-FAFNet 人体动作识别方法相比于同类算法的优势,本文选用MobileNetV3-Small[16]与RDA-TNet[14]作为对比算法。其中,MobileNetV3-Small 网络为单维特征网络。而RDATNet 为三维特征网络,它将简化后的VGG16 网络作为特征提取模块,并以特征拼接的方式实现三维特征的融合。基于3D-FAFNet 的构建方法,本文将MobileNetV3-Small 网络修改为三分支卷积神经网络结构,并分别加入特征平均融合方法与特征自适应融合方法以构建MobileNet-V3 平均融合网络与MobileNetV3 自适应融合网络。同时,本文将RDA-TNet 中的特征拼接融合方法分别替换为特征平均融合方法与特征自适应融合方法,构建RDA-T 平均融合网络以及RDA-T 自适应融合网络,并将它们作为本文的对比算法。通常可以采用受试者工作特征(Receiver Operating Characteristic,ROC)曲线[22]与AUC 值评估不同模型的综合性能。如图11 与图12 所示,为了更加充分地评估不同模型的泛化能力与综合性能,本文分别绘制了RDA-TNet与其余特征自适应融合网络在三维特征测试集上的准确率变化曲线与ROC 曲线。比较可知,3D-FAFNet 的平均准确率与AUC 值均高于其他网络,说明3D-FAFNet 具有更强的泛化能力与综合性能。同时,RDA-T 自适应融合网络的平均准确率与AUC 值略高于RDA-TNet,这表明相比于特征拼接融合方法,特征自适应融合方法拥有更好的特征融合能力。

图11 RDA-TNet与不同特征自适应融合网络准确率变化曲线

图12 RDA-TNet与不同特征自适应融合网络ROC曲线

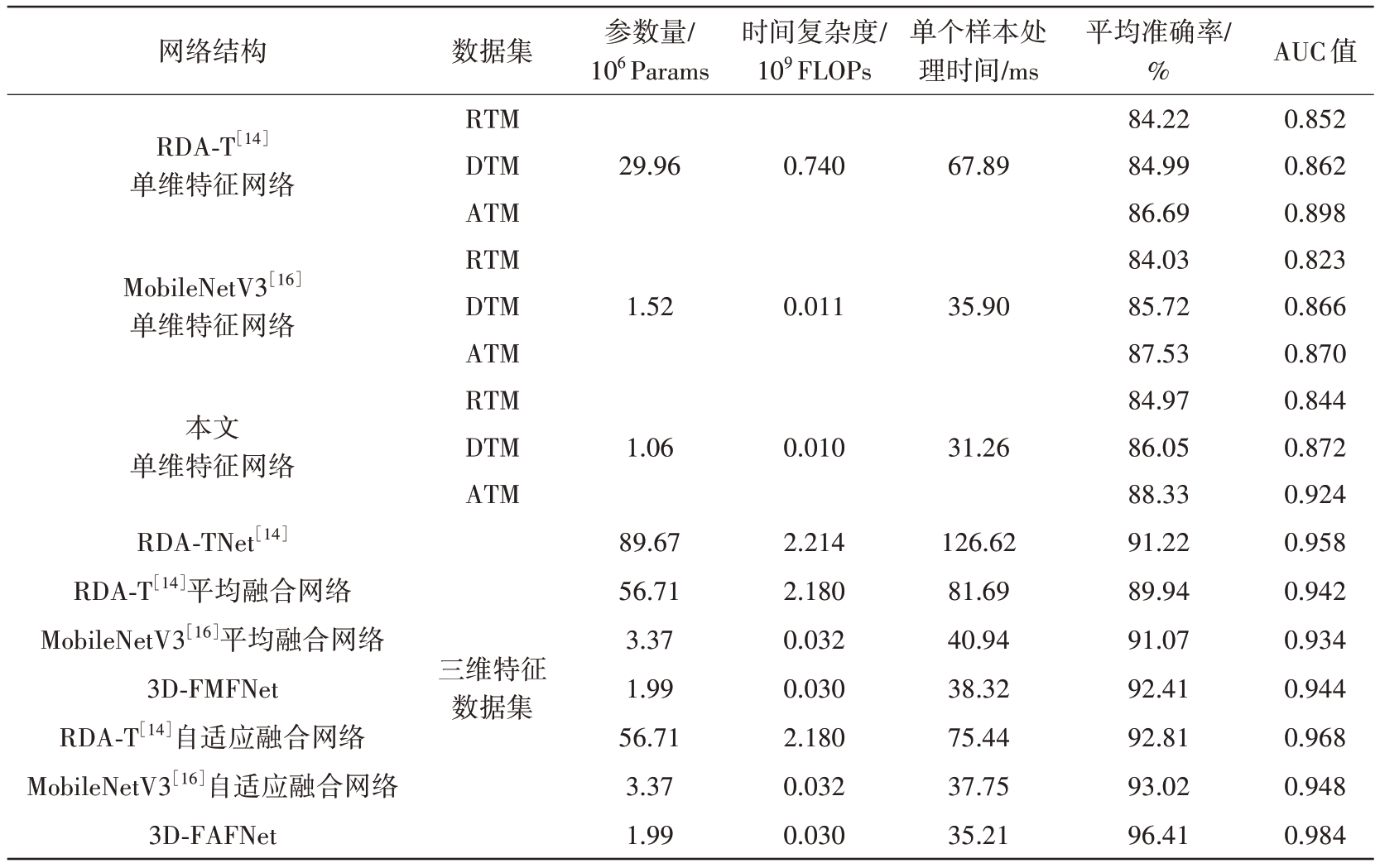

如表1 所示为不同人体动作识别方法的算法复杂度与在单维特征测试集、三维特征测试集上的精度比较。如表2 所示为3D-FAFNet 在三维特征测试集上进行随机一次测试得到的人体动作分类混淆矩阵。对比可知,基于三维特征人体动作识别方法的平均准确率与AUC 值均高于基于单维特征人体动作识别方法,说明三维特征数据集能够提供更加丰富的人体动作差异信息,体现了构建三维特征人体动作识别网络的必要性。同时,相比于采用三维特征平均融合方法与拼接融合方法的不同网络结构,采用特征自适应融合方法的网络结构的平均准确率提高了1.6%~4%,AUC 值提高了0.01~0.04,证明了本文所提特征自适应融合方法的有效性与通用性,可以适用于不同的网络结构。最后,本文所提出的3D-FAFNet 的平均准确率达到了96.41%,AUC 值达到了0.984,相比于其他特征融合方法的网络,将准确率提高了4%~6%,将AUC 值提高了0.03~0.05,对比单维特征识别方法则具有更加显著的提升,体现了3DFAFNet 的有效性与可靠性。此外,相较于RDATNet多分支网络结构,3D-FAFNet网络的模型参数量与时间复杂度大幅减少,单个样本的处理时间仅为35.2 ms,为后续的实时人体动作识别提供了有力支撑。

表1 不同人体动作识别方法的算法复杂度与精度对比

网络结构RDA-T[14]单维特征网络MobileNetV3[16]单维特征网络本文单维特征网络RDA-TNet[14]RDA-T[14]平均融合网络MobileNetV3[16]平均融合网络3D-FMFNet RDA-T[14]自适应融合网络MobileNetV3[16]自适应融合网络3D-FAFNet数据集RTM DTM ATM RTM DTM ATM RTM DTM ATM三维特征数据集参数量/106 Params 29.96 1.52 1.06 89.67 56.71 3.37 1.99 56.71 3.37 1.99时间复杂度/109 FLOPs 0.740 0.011 0.010 2.214 2.180 0.032 0.030 2.180 0.032 0.030单个样本处理时间/ms 67.89 35.90 31.26 126.62 81.69 40.94 38.32 75.44 37.75 35.21平均准确率/%84.22 84.99 86.69 84.03 85.72 87.53 84.97 86.05 88.33 91.22 89.94 91.07 92.41 92.81 93.02 96.41 AUC值0.852 0.862 0.898 0.823 0.866 0.870 0.844 0.872 0.924 0.958 0.942 0.934 0.944 0.968 0.948 0.984

表2 人体动作混淆矩阵

真实类别Stand WA WC WP-LR WP-RL Squat预测类别Stand 99 5 0 1 0 2 WA 0 92 0 0 0 0 WC 0 0 9 4 0 0 0 WP-LR 1 0 6 9 9 3 0 WP-RL 0 1 0 0 9 3 0 Squat 0 2 0 0 4 98

3 结束语

本文提出了一种基于毫米波雷达的三维特征自适应融合人体动作识别算法。首先,采用二维FFT 变换与MUSIC 算法对雷达回波信号进行处理,得到人体动作的距离特征、多普勒特征与角度特征,并在时域上拼接构建RTM、DTM 以及ATM数据集。然后,提出了一种三分支卷积神经网络结构与多维特征自适应融合方案,拓宽了网络的人体动作特征输入维度,实现了对多维特征的有效融合。最后,使用活动分类器实现对不同人体动作的识别。相比于单维特征识别方法与多种多维特征识别方法,所提方法能够有效提升人体动作识别准确率与AUC 值,证明了3D-FAFNet 的有效性与可靠性。后续的研究工作将从以下2 个角度出发:1)采集更加丰富的人体动作类型,如跌倒、抽搐等威胁人体健康的异常动作,增强模型的实用性;2)设计一种鲁棒高效的生成对抗网络,解决制备大量数据集困难的问题。

[1]RAY A, KOLEKAR M H. Transfer Learning and Its Extensive Appositeness in Human Activity Recognition: A Survey[J]. Expert Systems with Applications, 2023, 65(6):122538-122570.

[2]BODHE R, SIVAKUMAR S, SAKARKAR G, et al. Outdoor Activity Classification Using Smartphone Based Inertial Sensor Measurements[J]. Multimedia Tools and Applications,2024,15(1):1-27.

[3]ALEXAN A I, ALEXAN A R, ONIGA S. Real-Time Machine Learning for Human Activities Recognition Based on Wrist-Worn Wearable Devices[J]. Applied Sciences,2024,14(1):329-349.

[4]ZHANG Haoran, XU Linhai. Multi-STMT: Multi-Level Network for Human Activity Recognition Based on Wearable Sensors[J].IEEE Trans on Instrumentation and Measurement,2024,73(3):1-12.

[5]CAMARENA F, GONZALEZ-MENDOZA M, CHANG L,et al. An Overview of the Vision-Based Human Action Recognition Field[J]. Mathematical and Computational Applications,2023,28(2):61-80.

[6]XIN Wentian, LIU Ruyi, LIU Yi, et al. Transformer for Skeleton-Based Action Recognition: A Review of Recent Advances[J].Neurocomputing,2023(3):164-186.

[7]MOGHADDAM M G,SHIREHJINI A A N,SHIRMOHAMMADI S. A WiFi-Based Method for Recognizing Fine-Grained Multiple-Subject Human Activities[J].IEEE Trans on Instrumentation and Measurement, 2023, 72(1):1-13.

[8]GONG Danei, LIU Kezhong, PEI Dashuai, et al. Wi-Watch: WiFi-based Vigilant-Activity Recognition for Ship Bridge Watchkeeping Officers[J]. IEEE Trans on Instrumentation and Measurement,2023,72(2):645-662.

[9]LI Xinrong, WANG Xiaodong, YANG Qing, et al. Signal Processing for TDM MIMO FMCW Millimeter-Wave Radar Sensors[J].IEEE Access,2021,9(3):167959-167971.

[10]JIN Feng,SENGUPTA A,CAO Siyang.mmFall:Fall Detection Using 4-D mmWave Radar and a Hybrid Variational RNN AutoEncoder[J].IEEE Trans on Automation Science and Engineering,2022,19(2):1245-1257.

[11]蒋留兵,吴岷洋,车俐.FMCW 雷达基于光学字符识别的连续动作识别研究[J].雷达科学与技术,2023,21(1):74-81.

[12]CHAKRABORTY M, KUMAWAT H C, DHAVALE S V,et al. DIAT-μ RadHAR(Micro-Doppler Signature Dataset)& μ RadNet(A Lightweight DCNN)—for Human Suspicious Activity Recognition[J]. IEEE Sensors Journal,2022,22(7):6851-6858.

[13]屈乐乐,张丁元,杨天虹,等.基于双流特征融合的FMCW 雷达人体连续动作识别[J].雷达科学与技术,2022,20(5):565-572.

[14]王勇,吴金君,田增山,等.基于FMCW 雷达的多维参数手势识别算法[J].电子与信息学报,2019,41(4):822-829.

[15]ELBIR A M. DeepMUSIC: Multiple Signal Classification via Deep Learning[J].IEEESensorsLetters,2020,4(4):1-4.

[16]HOWARD A,SANDLER M,CHU G,et al.Searching for MobileNetV3 [C]// 2019 IEEE/CVF International Conference on Computer Vision,Seoul,Korea(South):IEEE,2019:1314-1324.

[17]HU Jie, SHEN Li, SUN Gang. Squeeze-and-Excitation Networks[C]// 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition, Salt Lake City, UT,USA:IEEE,2018:7132-7141.

[18]WANG Qilong, WU Banggu, ZHU Pengfei, et al. ECANet: Efficient Channel Attention for Deep Convolutional Neural Networks[C]// 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition,Seattle, WA,USA:IEEE,2020:11531-11539.

[19]ALHASSAN A M, ZAINON W M N W. Brain Tumor Classification in Magnetic Resonance Image Using Hard Swish-Based RELU Activation Function-Convolutional Neural Network[J].Neural Computing and Applications,2021,33(3):9075-9087.

[20]YING Xue. An Overview of Overfitting and Its Solutions[J]. Journal of Physics: Conference Series, 2019(2):22022-22029.

[21]JOHNSON O V,CHEW X,KHAW K W,et al.ps-CALR:Periodic-Shift Cosine Annealing Learning Rate for Deep Neural Networks[J]. IEEE Access, 2023, 11:139171-139186.

[22]JANSSENS A C J, MARTENS F K. Reflection on Modern Methods: Revisiting the Area Under the ROC Curve[J].International Journal of Epidemiology,2020,49(4):1397-1403.