0 引 言

基于合成孔径雷达(Synthetic Aperture Radar,SAR)的自动目标识别(Automatic Target Recognition, ATR)技术能准确预测目标类别,在实际中具有重要意义[1-3]。

传统SAR ATR 方法需要手工设计特征,严重依赖专业知识,且计算负担大、泛化性能较差[4-8]。近年来,深度学习驱动的SAR ATR 方法[9-11]备受关注。这类方法将特征提取与分类相结合,减少了对人工的依赖,表现出了优异的识别性能。尤其卷积神经网络(Convolutional Neural Network,CNN),已成为SAR ATR领域的首选技术。Chen等人[9]提出了一种全卷积网络(A-convnet),该网络去除了全连接架构,以减少训练参数。Amrani 等人[12]从特征提取角度出发,利用CNN 从SAR 图像中提取深度特征,并对其进行融合以获取更鲁棒的表示能力。然而CNN 方法通常是以固定尺寸大小的卷积核提取局部特征,在全局特征提取上受限。

本质上SAR 图像的目标可视为多个散射中心(Scattering Center, SC)的相干叠加,具有复杂的空间关系。因此SAR 图像自然地呈现出图结构特性,其中图像中的每个像素不仅与其邻近像素有关,还可能与远处的像素点产生联系,共同构筑一种复杂的图结构。传统的神经网络难以处理这类非结构化的图数据。而图卷积网络(Graph Convolutional Network, GCN)[13]凭借其对图数据的天然适应性,能直接揭示像素间的空间关联,可挖掘图像的全局特征信息。GCN 突破CNN 仅在固定局部区域内进行卷积的限制,已在目标识别领域得到初步应用。文献[14]将SAR 图像中目标的SC 构建成图数据,然后利用GCN 实现目标分类。然而它依赖SC 的预先提取,SC 提取的准确性直接影响识别结果,并且未实现端到端的识别。此外,GCN也被应用于Few-shot Learning,如Li 等人[15]提出一种基于图元学习的SAR ATR 方法。Yang 等人[16]将GCN 整合进关系网络,通过衡量样本间的相似度来实现SAR ATR。该类方法基于元学习,需要大量的元训练数据来学习泛化至新任务的策略,其性能取决于元训练任务与新任务之间的相似度。然而实际中,构建大量相似的元训练任务不切实际。

为了进一步提升识别性能,本研究充分利用GCN 与CNN 各自的优点,提出一种基于GCN 和CNN 联合的SAR ATR 方法。该方法采用GCN 模块与CNN 模块并行的方式实现了SAR 图像的端到端识别。SAR 图像被分别投送给两个模块:CNN 模块用于提取SAR 图像的局部特征;GCN 模块首先将SAR 图像构建为图数据,然后通过GCN模块提取全局特征。为增强模型对图数据的学习能力,设计了多尺度GCN 来融合不同尺度的特征。最后将GCN 和CNN 提取的特征进行融合,进而完成目标识别。此外,采用标签平滑技术以减轻有限训练数据带来的过拟合问题。通过端到端的训练策略联合优化GCN 与CNN 参数,实现两者的相互补充和协同作用,达到了高精度识别效果。

1 基于GCN和CNN联合的SAR自动目标识别

1.1 总体介绍

本研究提出的基于GCN 和CNN 联合的SAR自动目标识别方法如图1 所示。此方法融合了CNN 和GCN 两大核心模块:CNN 模块以原始SAR图像为输入,通过多层次卷积操作提取出图像的局部特征;与此同时,GCN 模块的首要步骤是构造图数据,这一过程包括将SAR 图像划分为多个子图,将每个子图视为一个独立节点,使用K 近邻计算节点间的相互连接关系,形成邻接矩阵。随后,这些节点及其邻接矩阵被输入到GCN 中提取全局特征。最终,将这两个模块所提取的特征融合在一起,并借助标签平滑策略来计算分类损失,联合优化CNN 和GCN 的参数,实现SAR 图像端到端的识别。值得注意的是,为了更好地表征图数据,GCN 模块是由多个GCN 层拼接构造成的多尺度GCN。而CNN 模块直接采用了广受欢迎的网络[13],为了聚焦于所提方法的核心创新,对其详细配置不再赘述。后续部分将进一步详细阐述本方法的其他关键环节。

图1 所提方法总体架构

1.2 K近邻构图

图卷积网络只能作用于图结构数据,因此需要将SAR 图像构建为拓扑图结构。由于SAR 是单通道的灰度图,将SAR 图像中每一个像素点视为一个节点是无法构造拓扑图的。为了实现端到端的操作并且提升模型的泛化性,本研究将SAR 图像切分为若干子图,然后采用K 近邻的方式构造图数据。K近邻构图步骤如下:

1) 特征表示:首先将SAR 图像样本分割为一系列H × H像素大小的子图,然后将每个子图视为一个节点,并排列为一维的向量视为节点特征向量。因此每个样本可以用X ={ x1, x2,…, xn}T表示,其中xi为当前样本的第i个节点特征向量。

2) 相似度计算:计算任意两节点xi 和xj 之间的距离(或相似度)。本文距离度量采用的是欧几里得距离,计算公式为

式中 |· |2为2范数。

3) 选择K 近邻:对于每个节点xi,找到与其距离最近的K个点。

4) 构建图:构建图G =( V, E ),其中V 是节点集合,E 是边集合。如果节点xj 是xi 的K 近邻之一,则图中存在一条从i 到j 的边。通常用邻接矩阵A 表示节点的邻接关系,其中矩阵的元素aij = 1表示节点j是节点i的一个近邻。

1.3 多尺度GCN

介绍多尺度GCN 之前,首先介绍单层GCN 的工作流程。GCN 的输入有两个:节点的特征向量X ={ x1, x2,…, xn}T和邻接矩阵A。在训练过程中,A 通常被视为常量。GCN 的流程可概括为以下3个步骤:

1) 节点特征聚合:对特征向量和邻接矩阵进行矩阵乘法运算。这一步骤的核心思想是同时聚合节点自身及其邻居节点的信息,将它们的特征信息进行融合和整合。

2) 全局权重加权:将聚合得到的信息与全局共享的权重矩阵相乘。这一步骤有助于加权调节不同节点特征之间的重要性,以便更好地反映节点之间的相互关系。

3) 非线性映射:通过添加激活函数完成非线性映射。这一步骤能够使得GCN 模型能够学习复杂的非线性关系,并得到更具有判别性和表达能力的特征表示。

GCN 的核心思想在于利用图中节点及其邻域节点的特征信息来生成新的节点特征表示,从而实现图数据的特征提取和表示学习。通过这种方式,GCN 能够有效地捕捉图结构中的全局信息,为图数据的下游任务提供更加有效的特征表示。图2展示了GCN的聚集邻居节点特征信息的过程,它直观地说明了GCN 模型是如何从图中提取和整合信息的。

图2 聚集邻居节点过程

如图2所示,xj、xk、xm和xn是节点xi邻居节点,S( i )是节点xi的邻居集合。经过卷积聚合操作后,节点xi生成新的节点表示为hi,公式表示为

则GCN的一个神经网络层可以定义如下:

式中:H = X 是GCN 网络的初始输入,是初始图像特征;W0 是可训练的参数矩阵;σ(·)是非线性映射函数,本文中采用ReLU激活函数。

公式(3)只是一个简单的图卷积前向传播公式。邻接矩阵A 与节点特征矩阵H 相乘时,只聚合了邻居节点的信息,忽略了自身的特征信息。为了解决此问题,将邻接矩阵A 与单位对角矩阵I相加的结果 替换A,表达如下:

替换A,表达如下:

接着需对 进行归一化处理,若不进行归一化,进行卷积操作时,节点度数多的节点计算得到的特征向量会变得很大,度数少的节点特征向量会很小,这样会改变每个节点特征原本的分布,产生不可预测的问题,导致梯度消失或爆炸。因此,通常用度矩阵D 的逆矩阵乘以

进行归一化处理,若不进行归一化,进行卷积操作时,节点度数多的节点计算得到的特征向量会变得很大,度数少的节点特征向量会很小,这样会改变每个节点特征原本的分布,产生不可预测的问题,导致梯度消失或爆炸。因此,通常用度矩阵D 的逆矩阵乘以 完成归一化。然而相乘之后的邻接矩阵失去了对称性,影响后续的计算,故将D-1 拆分成两个

完成归一化。然而相乘之后的邻接矩阵失去了对称性,影响后续的计算,故将D-1 拆分成两个![]() ,分别对

,分别对 进行左乘和右乘,即可得到对称归一化的邻接矩阵:

进行左乘和右乘,即可得到对称归一化的邻接矩阵:

式中度矩阵D为对角阵,对角元素Dii =∑jaij。

故单层GCN公式修正为

与CNN 中的多层堆叠类似,可堆叠多个GCN层以提升模型的表征能力,多层GCN公式如下:

式中l 表示GCN 的层数,H0 = X,Wl 表示第l 层的权重参数。

然而随着迭代次数的增加和层数的加深,图卷积神经网络中的节点往往趋于过平滑(Over Smooth, OS)状态,即同一子图的节点具有相同的值或特征。本研究引入ResNet 中的残差思想,通过添加跳跃连接将各层的输入与输出进行拼接。最后还将每层的输出在特征维度上进行拼接融合,使得每一层的特征都能够被有效利用,以更好的学习不同尺度相邻节点的信息。因此,构建了如图3所示的多尺度GCN。

图3 多尺度GCN

经过多尺度特征的拼接后,此时的特征可表示为Hcon =[H0, H1,…, HL],随后经过一个全连接层进行映射,最终输出多尺度GCN 提取的全局特征。

1.4 损失函数

如图1 所示,对CNN 和GCN 模块提取的特征进行融合后,即可得到特征Hfusion,然后输入给一个全连接中,然后通过Softmax函数预测类别结果,可以表示为

式中Wfc和b分别为权重矩阵和偏置向量。

此外,由于SAR 图像通常样本量是有限的,本文采用标签平滑[14]操作以防止过拟合。对于标记为真值y的训练样本,标签平滑可以表示为

式中,ε 为平滑参数,yone-hot 为真实标签y 的one-hot编码向量,T 表示训练数据的类别数量。因此,所提方法的最终损失函数如下所示:

式中,N 为训练集中的样本个数, i 为模型的输出概率。

i 为模型的输出概率。

1.5 训练过程

所提方法在训练过程中将SAR 图像训练集分别输入CNN 模块和GCN 模块。在CNN 模块中,利用卷积神经网络提取特征FC。在GCN 模块中,首先采用1.2 节的方式将SAR 图像构造为图数据,然后对图数据使用多尺度GCN 提取特征Hcon。接下来将两个模块提取的特征进行融合,得到融合特征Hfusion,然后使用全连接层进行映射并利用激活函数得到目标类别。最后,借助标签平滑策略计算损失L,并利用梯度下降的方式最小化损失值,进而同步更新CNN和GCN模块参数。由于优化目标是使损失值逐渐减小,这意味着识别率将会逐步提高。具体的训练细节可参见表1。

表1 训练算法

算法:训练过程输入:目标SAR训练集{ }Xtrain,Ytrain,Xtrain训练集的SAR图像,Ytrain训练集标签。迭代次数N = 500,批大小mbatch = 64,随机初始化CNN参数ωCNN、GCN参数ωGCN,优化器Adam,参数b1 = 0.9,b2 =0.999,学习率lr = 0.000 2。输出:CNN参数ωCNN、GCN参数ωGCN 1) For i=1 To N do 2) For j=1 To mbatch do 3) 从训练集采样(x, y)~{ }Xtrain,Ytrain,并构造图数据。4) 计算输出损失L,同时更新参数ωCNN ←Adam(1 mbatch ∑j = 1 mbatch ∂L∂ωCNN, ωCNN, b1,b2,lr)和参数ωGCN ←Adam(1 mbatch ∑j = 1 mbatch ∂L∂ωGCN, ωGCN, b1, b2, lr)。5) End for 6) End for

2 实验结果和分析

2.1 数据描述和实验设置

为了评估所提方法的性能,本文实验采用公开实测的MSTAR 数据集[17]和OpenSARship 数据集[18]进行验证。

MSTAR 数据集收集了X波段机载SAR 图像的10 类地面静态军用车辆目标,采集使用的是水平极化方式,方位向和距离向分辨率为0.3 m,方位角间隔约为0.03°。由于俯仰角15°、17°的数据比较齐全,通常选用17°的样本作为训练,15°的作为测试。图4 展示了该数据集目标的光学图像和SAR图像,具体的目标类别和数量如表2所示。

表2 实验选用的MSTAR数据集

类别BMP2(SN_9566)BTR70(SN_C71)T72(SN_132)BTR60(k10yt7532)T62(e51)2S1(b01)BRDM2(e71)D7 ZIL131(e12)ZSU234(d08)17°232 233 232 256 299 299 298 299 299 299 15°196 196 196 195 273 274 274 274 274 274

图4 MSTAR 10类目标的光学图像和SAR图像

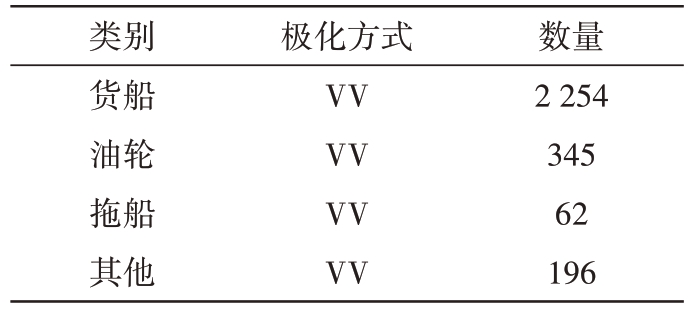

OpenSARship 数据集是由上海交通大学高级传感技术中心(AST)公开用于SAR 图像船只检测和分类的数据集。本文使用的是OpenSARship 1.0版本的数据,其中包含了41 幅哨兵一号(Sentinel-1)SAR 图像,共有11 346 个船只,包含多种舰船类型,如图5所示。由于该数据集中的各类别目标数量相差较大,有的仅有几个甚至一个样本,因此本文挑选4 类数量相对较多的目标类别构建了训练集和测试集,如表3 所示。实验时,训练集和测试集按比例7∶3随机划分,并且为了减少实验的随机性,取10次重复实验结果的平均值。

表3 实验采用的OpenSARship数据集

类别货船油轮拖船其他极化方式VV VV VV VV数量2 254 345 62 196

图5 OpenSARship数据集SAR图像

因为目标往往只占据整幅SAR 图像的一小部分,为了降低背景无用信息的影响,实验中所有样本被裁剪为64 × 64 像素大小,并做均值方差归一化预处理。K 近邻构图的超参数K 设置为9,分割的子图像素大小为16 × 16。GCN的层数设置为3,每个GCN层的输出特征维度为512,优化器为Adam,学习率为0.001,迭代次数为1 000。标签平滑因子设置为0.1,CNN 和GCN 模块采用拼接融合方式进行特征融合。此外还对比了几种传统的SAR ATR方法和基于深度学习的方法来评估所提方法的性能,评价指标为识别准确率/识别率[19]。传统方法包括稀疏表示分类(Sparse Representation-based Classification, SRC)[20]、K 近邻(K-Nearest Neighbor,KNN)[21]、支 持 向 量 机(Support Vector Machine,SVM)[21]、字典学习和联合动态稀疏表示(DL-JDSR)[22],其中为了减少人为提取特征的干扰,KNN与SVM 方法与文献[21]一致,均采用基于主成分分析(Principal Component Analysis, PCA)方法降维到100 维后的特征数据,KNN 中参数K 设置为3;基于深度学习的方法包括VGGNet(VGG16)[23]、DenseNet(DenseNet101)[24]、A-ConvNet[9]、基于分量分析的多尺度CNN(CA-MCNN)[25]以及SC 与GCN联合的方法(SC-GCN)[16]。

所有实验均在软件平台Python 3.11、深度学习Pytorch 2.0 库上完成,硬件设备为Dell Precision 5820 workstation(CPU:Intel i9-10920X,GPU:Ge-Force GTX 3090,RAM:64GB,Windows 10)。

2.2 模型稳定性分析

在验证识别结果之前,首先检验所提模型训练过程损失函数和识别率的变化情况,如图6所示。

图6 模型的训练过程

从图6(a)可以观察到,随着训练次数的增加,损失值迅速减小,并在大约100次训练后趋于稳定并收敛到最小值。这表明所提出的模型在训练过程中能够稳定地收敛。此外,图6(b)显示的训练集识别率随着训练次数的增加也呈现迅速提升并趋于稳定的趋势。因此,综合考虑两幅图的曲线变化,可以得出结论,所提出的网络模型能够进行有效训练,并且在训练集上能够获得较高的识别准确率。这为后续在测试集上的准确识别提供了保障。

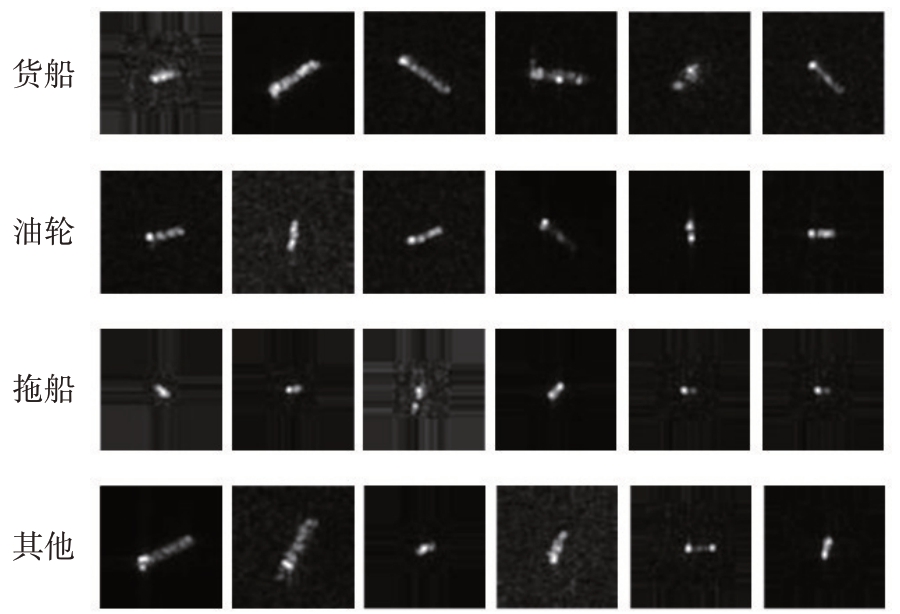

2.3 识别结果

对MSTAR 和OpenSARship 数据的识别结果如图7所示。可以观察到,基于深度学习方法的识别率普遍优于传统方法。值得注意的是,在本文的实验中,光学图像中表现较好的VGGNet 和DenseNet在SAR 图像识别中表现不佳。这是因为SAR 图像与光学图像在性质上存在本质区别,SAR 图像是通过雷达系统发送和接收返回的微波信号获得的,其呈现为一系列SC 的相干叠加特性。因此,SAR 图像主要包含物体几何结构的信息,而非光学特性。此外,SAR 图像的性能在很大程度上取决于用于训练的数据集的大小,而本文采用的SAR 图像数据集是有限的,因此它们的识别率不是最优的。A-ConvNet 虽然采用了全卷积网络实现了端到端的识别,但对识别率的提升仍然有限。另外,CA-MCNN 通过将SC 特征与CNN 特征融合,明显提升了识别率。SC-GCN 通过将SC 构造为图数据,并使用多尺度GCN 完成识别,也大大提升了识别率。然而这些方法仍需要预先提取SC,SC 提取的准确度会影响最终的准确率,并且也未实现端到端的识别。相比之下,所提方法不仅实现了端到端的识别,并且在两个数据集上均表现最优,特别是在不平衡的OpenSARship数据集上,展现出了较强的鲁棒性和泛化性。

图7 识别结果

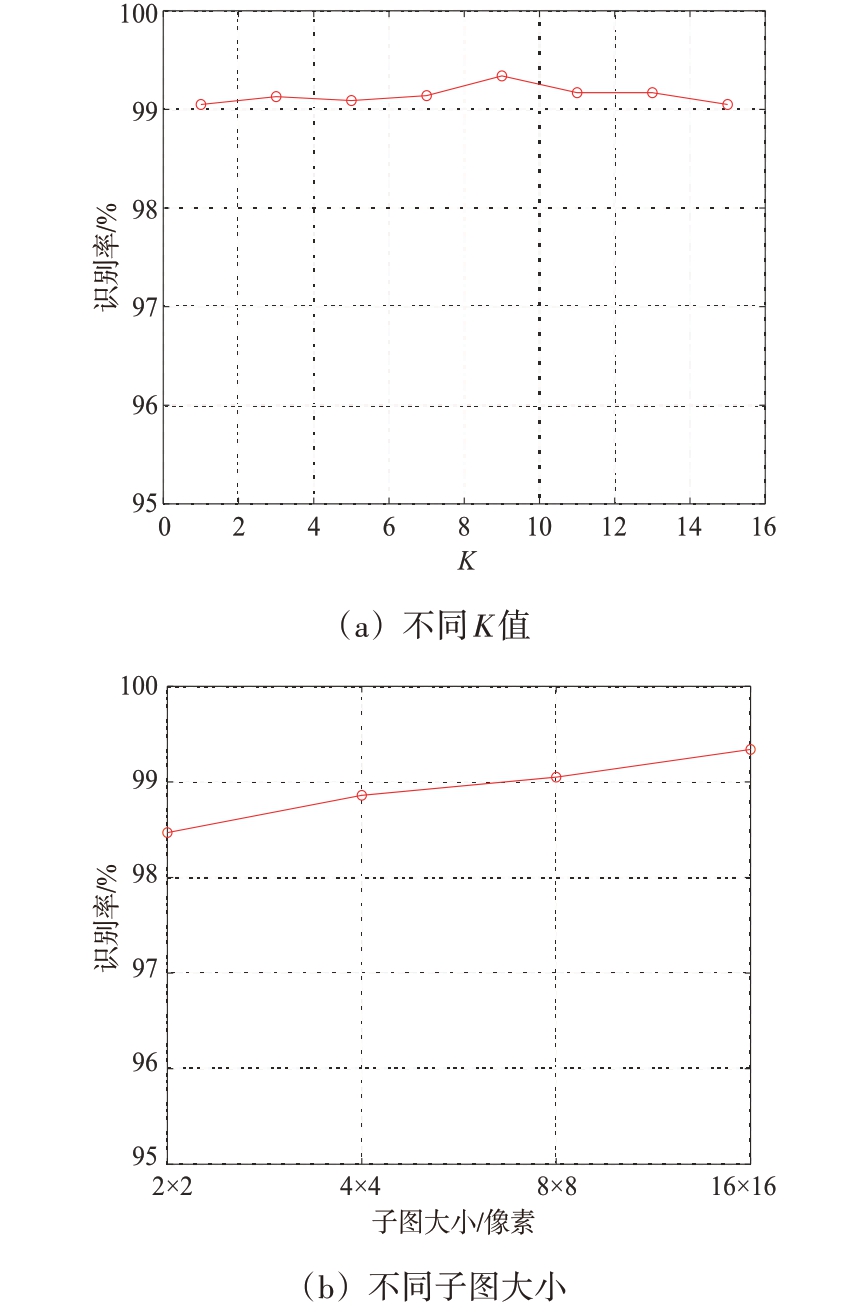

2.4 消融实验

本节基于MSTAR 数据对模型进行消融实验,以分析GCN 多尺度融合和标签平滑对识别率的影响,实验结果如表4 所示。对比前两行,可以发现标签平滑的应用提高了1.44%的准确率。这是因为在有限的SAR 图像训练数据下,标签平滑可以在一定程度上缓解过拟合现象。同样地,对比第1行和第3 行,可发现多尺度GCN 融合也能提升识别率,说明了多尺度的融合对SAR 图像的表征是有益的。从第1 行和第4 行可以看出,同时使用多尺度融合和标签平滑,能够较大程度提升识别率,对MSTAR 数据的识别率提升约为1.94%。总的来说,在SAR 图像识别任务中,多尺度特征融合和标签平滑的结合使用可以有效地提升识别性能。

表4 消融实验

GCN多尺度融合××√√标签平滑×√×√识别率/%97.40 98.84 98.88 99.34

2.5 模型分析

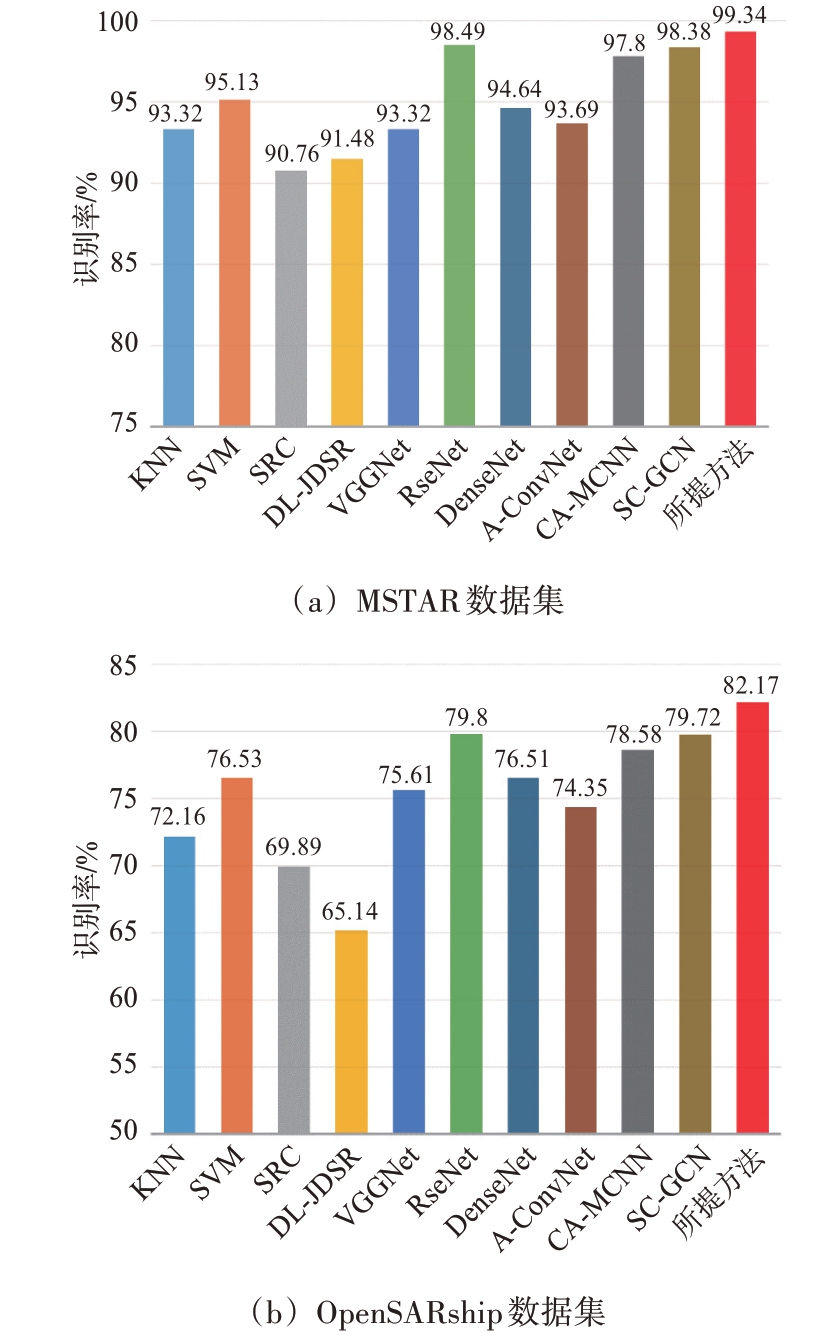

本节仍以MSTAR 数据为例,首先进行不同超参数的识别实验,分析图构建阶段不同K值和子图大小对模型识别性能的影响。结果如图8所示。

图8 识别率随K构图参数的变化

1) K 值的影响:从图8(a)看出,K 的最优值为9,并且随着K值的不同识别率仅有轻微的变化,说明所提方法对K值不敏感。

2) 子图大小的影响:从图8(b)可以看出,子图大小的最优值为16 × 16。当它小于16 × 16时,性能明显下降。说明当分割的子图变小时,可能会丢失一些重要的全局信息或者节点间的长距离依赖关系,进而影响模型的性能。

在图1 的方案中,CNN 模块和GCN 模块提取的特征有3种不同的融合方式,接下来分析不同融合方式对识别率的影响。如图9所示,可以发现拼接融合是最优的。这是因为加性和乘性融合在融合时更改了原始特征,可能会破坏特征表示。具体来说,由于加性融合是简单地将两个特征向量相加,这可能会导致某些特征信息被另一种特征所掩盖,从而降低了特征的独立性和多样性。此外,加性融合并没有明确地考虑到特征之间的互相影响,可能导致融合后的特征表达不够优化。而乘性融合它可能会引入非线性,导致特征之间的交互更加复杂。并且乘性融合对于特征的值较小的部分会放大其影响,这可能会导致模型对噪声或不重要的特征过度敏感。相反拼接融合直接将两组特征拼接在一起,保留了两者的所有信息,包括局部和全局特征,提供了更加丰富的特征表示。此时模型可以自由地学习每个特征的权重,从而更好地适应任务需求。这种灵活性使得模型能够更好地捕捉数据之间的复杂关系,提高了模型的性能和泛化能力。

图9 不同融合方式识别结果

3 结束语

为了更有效地利用SAR 图像特性,本文结合GCN 与CNN 各自的优点,提出了一种基于GCN 和CNN 联合的SAR ATR 方法。通过将多尺度GCN与CNN 模块提取的特征融合来增强模型对数据的表征能力,并且采用标签平滑技术以缓解过拟合现象。通过端到端的训练策略联合优化GCN 与CNN 的参数,实现了两者的相互补充和协同作用,从而达到了高精度的SAR 图像目标识别。通过在MSTAR 和OpenSARship 数据集上的实验验证表明,所提方法在识别性能上优于现有技术,并展现出更加卓越的泛化能力。

未来的工作将探索CNN和GCN提取特征的可视化问题,以增强模型的可解释性和可控性。此外还将集中在GCN 的动态学习上,以增强开放集条件下对各种SAR 目标的自适应能力,并进一步提高所提方法在不平衡SAR数据集上的鲁棒性。

[1] QIN Jikai, LIU Zheng, RAN Lei, et al.A Target SAR Image Expansion Method Based on Conditional Wasserstein Deep Convolutional GAN for Automatic Target Recognition[J].IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing, 2022, 15:7153-7170.

[2] 刘旗,刘永祥,张新禹.基于特征注意力融合元残差网络的小样本SAR 目标识别[J].电子学报,2023,51(9):2366-2378.

[3] 袁雪,韦楠楠,张兴敢.利用低数据率HRRP 序列进行弹道中段目标识别[J].雷达科学与技术,2023,21(5):559-567.

[4] QIN Jikai, LIU Zheng, RAN Lei, et al.An SAR Image Automatic Target Recognition Method Based on the Scattering Parameter Gaussian Mixture Model[J].Remote Sensing, 2023, 15(15):3800.

[5] 邢孟道,谢意远,高悦欣,等.电磁散射特征提取与成像识别算法综述[J].雷达学报,2022,11(6):921-942.

[6] LIU Mengxing, CHEN Shaobo.Multi-Manifold Based Sparse Representation with Application to SAR Target Configuration Recognition[J].Radio Science, 2022, 57(7):1-11.

[7] SONG Wanying, QUAN Huan, CHEN Yuang, et al.SAR Image Feature Selection and Change Detection Based on Sparse Coefficient Correlation[C]//2022 17th International Conference on Control, Automation, Robotics and Vision, Singapore:IEEE, 2022:326-329.

[8] DONG Qin.Recognition Method of Dim and Small Targets in SAR Images Based on Machine Vision[J].International Journal of Advanced Computer Science and Applications, 2022, 13(9):982-990.

[9] CHEN Sizhe, WANG Haipeng, XU Feng, et al.Target Classification Using the Deep Convolutional Networks for SAR Images[J].IEEE Trans on Geoscience and Remote Sensing, 2016, 55:4806-4817.

[10] LI Jianwei, YU Zhentao, YU Lu, et al.A Comprehensive Survey on SAR ATR in Deep-Learning Era[J].Remote Sensing, 2023, 15(5):1454.

[11] 施端阳,林强,胡冰,等.深度学习在雷达目标检测中的应用综述[J].雷达科学与技术,2022,20(6):589-605.

[12] AMRANI Moussa, JIANG Feng.Deep Feature Extraction and Combination for Synthetic Aperture Radar Target Classification[J].Journal of Applied Remote Sensing,2017, 11(4):042616.

[13] BHATTI U A, TANG Hao, WU Guilu, et al.Deep Learning with Graph Convolutional Networks: an Overview and Latest Applications in Computational Intelligence[J].International Journal of Intelligent Systems, 2023(1):1-28.

[14] LI Chen, DU Lan, LI Yi, et al.A Novel SAR Target Recognition Method Combining Electromagnetic Scattering Information and GCN[J].IEEE Geoscience and Remote Sensing Letters, 2022, 19:1-5.

[15] LI Liupeng, LIU Jing, SU Liyu, et al.A Novel Graph Metalearning Method for SAR Target Recognition[J].IEEE Geoscience and Remote Sensing Letters, 2021, 18:1-5.

[16] YANG Rui, XU Xin, LI Xirong, et al.Learning Relation by Graph Neural Network for SAR Image Few-shot Learning[C]// 2020 IEEE International Geoscience and Remote Sensing Symposium, Waikoloa, HI, USA: IEEE,2020:1743-1746.

[17] SHI Ji.SAR Target Recognition Method of MSTAR Data Set Based on Multi-Feature Fusion[C]//2022 International Conference on Big Data, Information and Computer Network, Sanya, China:IEEE, 2022:626-632.

[18] HUANG Lanqing, LIU Bin, LI Boying, et al.OpenSARShip: A Dataset Dedicated to Sentinel-1 Ship Interpretation[J].IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing, 2017, 11(1):195-208.

[19] 王艺卉,闫文君,段可欣,等.基于数据增强的小样本辐射源个体识别方法[J].雷达科学与技术,2024,22(1):104-110.

[20] YANG Yinan, QIU Yuxia, LU Chao.Automatic Target Classification-Experiments on the MSTAR SAR Images[C]//Sixth International Conference on Software Engineering, Artificial Intelligence, Networking and Parallel/Distributed Computing and First ACIS International Workshop on Self-Assembling Wireless Network, Towson, MD, USA:IEEE, 2005:2-7.

[21] SONG Haibo, JI Kefeng, ZHANG Yunshu, et al.Sparse Representation-Based SAR Image Target Classification on the 10-Class MSTAR Data Set[J].Applied Sciences,2016, 6(1):1-11.

[22] SUN Yongguang, DU Lan, WANG Yan, et al.SAR Automatic Target Recognition Based on Dictionary Learning and Joint Dynamic Sparse Representation[J].IEEE Geoscience and Remote Sensing Letters, 2016, 13:1777-1781.

[23] ZHAO Dandan, ZHANG Zhe, LU Dongdong, et al.CVGGNet: Ship Recognition for SAR Images Based on Complex-Valued Convolutional Neural Network[J].IEEE Geoscience and Remote Sensing Letters, 2023, 20:1-5.

[24] CHENG Dongdong, DONG Zhangyu, WANG Jun, et al.A Dual-Scale Siamese Densely Connected Network with MRF for SAR Image Classification[J].Remote Sensing Letters, 2022, 13(3):247-257.

[25] LI Yi, DU Lan, WEI Di.Multiscale CNN Based on Component Analysis for SAR ATR[J].IEEE Trans on Geoscience and Remote Sensing, 2021, 60:1-12.